Ausschuss oder Gutteil?

Produktqualität mit der Kristallkugel prüfen

Handelt es sich bei dem aktuell produzierten Artikel um Ausschuss oder Gutstück? Mit Predictive Quality ist der Blick in die digitale Glaskugel möglich. Das Ziel dabei ist, fehlerhafte Produkte früh auszuschleusen und so unnötigen Aufwand und Kosten zu sparen.

Bisher wurden Fehler häufig erst im Nachhinein diagnostiziert, was in der Regel zu zusätzlichen Kosten führte. Eine durch Predictive Quality erweiterte Qualitätskontrolle ermöglicht es, im laufenden Betrieb Prozessdaten in Echtzeit zu interpretieren und daraus Qualitätsvorhersagen abzuleiten. Hierbei werden gesammelte Daten aus relevanten Datenquellen auf Risikomuster analysiert, um die Qualität zu verbessern und Kosten zu sparen.

Predictive Quality lebt von Daten

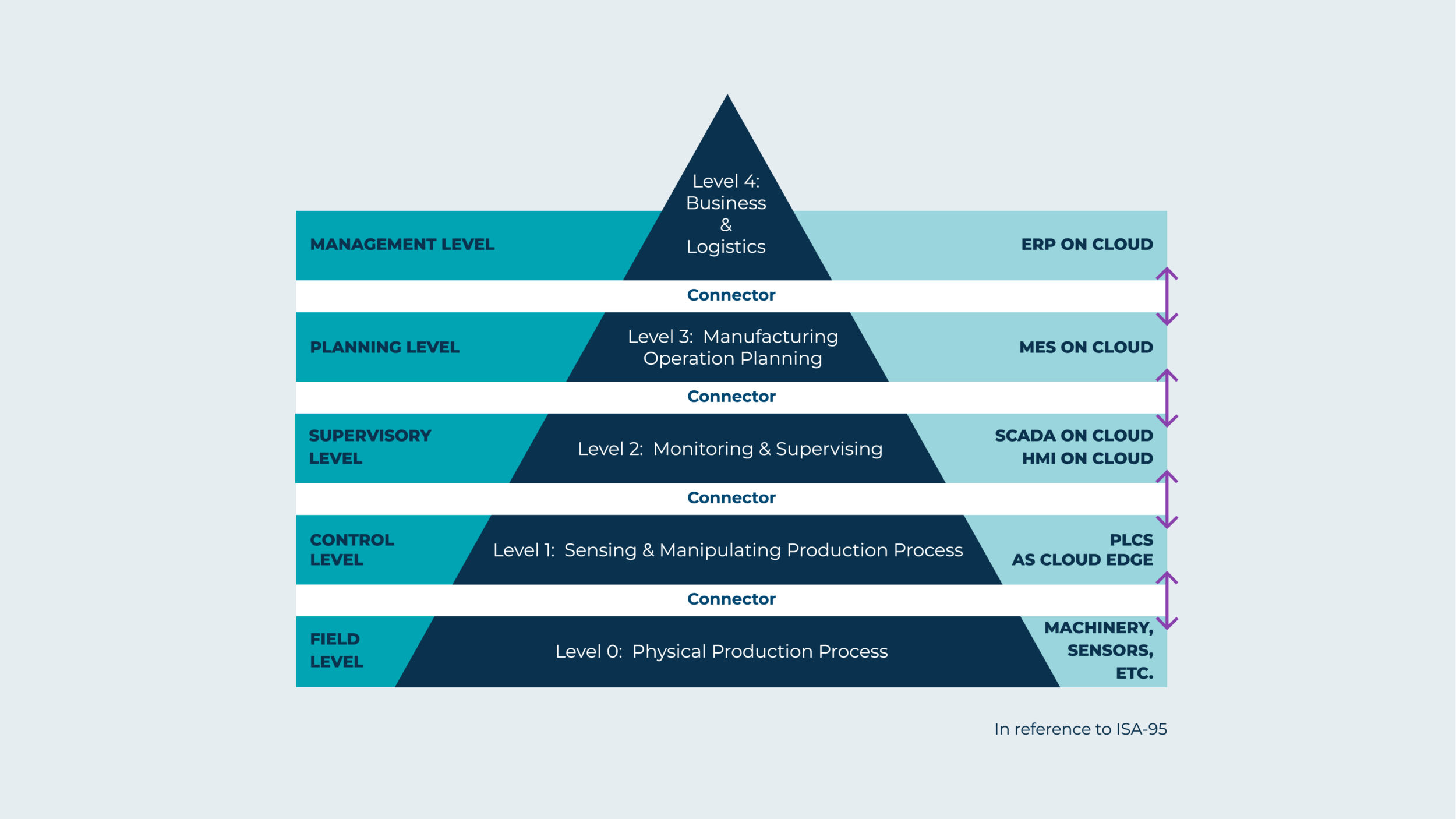

Die Grundlage für Predictive Quality sind Daten, Daten, Daten. Die Anwendung führt Qualitäts-, Maschinen- und Sensordaten sowie Umgebungsdaten vor Ort oder in der Cloud zusammen. Es werden dazu möglichst umfangreiche und vielfältige Prozessdaten benötigt, die sich zwecks Qualitätseinstufung mit dazu passenden Qualitätsdaten korrelieren lassen. Für Fertigungsunternehmen bedeutet dies: Je größer und qualifizierter die Datenbasis, desto besser die Voraussetzungen, Zuverlässigkeit und Genauigkeit der Predictive Quality. Aber woher stammen diese Informationen? Bei der Erfassung relevanter Daten kann ein modernes Manufacturing Execution System (MES) und etwa ein Edge Device zur schnellen, dezentralen Datenverarbeitung unterstützen. Auf dieser Datenbasis lässt sich ein Vorhersagemodell entwickeln, das in die Predictive-Quality-Anwendung einfließt. Hier werden die Daten in Realtime interpretiert und es erfolgt die Einordnung in ein gutes Teil oder Ausschuss sowie die Wahrscheinlichkeit für die Richtigkeit der Vorhersage. So kann die automatische Qualitätsentscheidung fallen, bei der in der Regel Machine-Learning-Verfahren zum Einsatz kommen. Das Manufacturing Execution System (MES) HYDRA optimiert Produktionsprozesse für Fertigungsunternehmen, um Wettbewerbsvorteile zu erzielen. ‣ weiterlesen

MES-Integrator und 360-Grad-Partner für optimierte Fertigung

Voraussetzungen und Grundlagen

Das Internet of Things (IoT) spielt als Voraussetzung für die Umsetzung der prädiktiven Qualitätssicherung eine übergeordnete Rolle. Es vernetzt die Informationen der Fertigung mit dem ECO-System des Produktes außerhalb der Fabrik. Somit eröffnen sich neue Möglichkeiten der automatisierten Steuerung von Aktionen und Services rund um ein Produkt bzw. Anlagen und Maschinen innerhalb des Fertigungsprozesses. Für die Einführung einer Predictive-Quality-Lösung müssen entsprechende MES-Daten mit IoT-Daten verknüpft werden, so dass diese in Echtzeit z.B. auf einem Edge Device verarbeitet werden können. Mittels entsprechender Interfaces können dann Digital-Twin-Daten der Maschinen sowie Informationen über das erzeugte Produkt (wie die in ihm verbauten Halberzeugnisse) an IIoT-Infrastrukturen weitergeleitet werden, um zusätzliche Analysen durchzuführen.

Daten und Prozesse verknüpfen

Wenn alle Daten zur Verfügung stehen, gilt es, Verbindungen zu schaffen und alle Prozessschritte miteinander zu verketten. Eine Predictive-Quality-Anwendung ist jedoch immer individuell zu sehen. Denn die Produktionsprozesse in Fabriken sind unterschiedlich und weisen oftmals Abweichungen in Maschinen und Toleranzen auf. Die Predictive-Quality-Lösungen und korrespondierende Anwendungen wie das MES müssen daher auf die Anforderungen des Unternehmens zugeschnitten werden. Um die Pflege und Skalierung der Lösungen in Eigenregie zu sichern, brauchen Unternehmen geschulte Verantwortliche wie MES- und IoT-Experten.

Entwicklung und Perspektiven

Predictive Quality ist eine logische Ergänzung zu Predictive Maintenance (Vorhersage von Störungen und Maschinenausfällen) sowie Lösungen generell, die vorausschauend arbeiten, wie Predictive Planning. Sie alle haben Kosteneinsparungen und höhere Zuverlässigkeit beziehungsweise Qualität durch automatisierte Prozesse zum Ziel. Noch ist der Markt im Bereich Predictive Quality nicht allzu stark entwickelt. Durch die zunehmende Kombination von IoT- und MES-Daten in der Produktion ist der Weg zum verstärkten Einsatz dieser Szenarien jedoch geebnet. Standardisierung, Maschineninterfaces und Digital-Twin-Daten werden hierbei an Bedeutung gewinnen. Der Markt für Digital Twins soll in den kommenden Jahren jedenfalls deutlich wachsen. Gartner prognostiziert, dass 2021 bereits die Hälfte aller großen Industrieunternehmen digitale Zwillinge im Einsatz haben werden.

Was folgt auf Predictive Quality?

Derzeit beschränkt sich das Feld der vorausschauenden Anwendungen noch in erster Linie auf die Fabrik. In Zukunft wird auch das Umfeld – z.B. Lieferanten – vermehrt einbezogen werden, um nachfolgende Services und smarte Produkte (die sich beispielsweise selbst warten) zu ermöglichen. Durch automatische Rückschlüsse aus erhobenen Daten zwecks Predictive Services könnte beispielsweise ein Automobilhersteller erkennen, wann welche Produkte Ersatzteile benötigen. Damit lassen sich Serviceeinsätze für die überwachten Produkte vorbeugend planen, Ausfälle vermeiden und vieles mehr.

Peter Bollinger ist CEO der iTAC Software AG.

Peter Bollinger ist CEO der iTAC Software AG.