Machine Learning und Big Data

im Dienst der Qualitätssicherung

Innovative Produkte erfordern oft komplexe Fertigungsprozesse am Rand des technisch Machbaren. Vollprüfungen und hohe Ausschussraten sind häufige Folgen. Mit prädiktiver Qualitätssicherung auf Basis von Prozess- und Betriebsdaten lassen sich die anfallenden Kosten reduzieren. Dazu wird im Produktionstakt vorausschauend quasi in Echtzeit auf die Qualität der gefertigten Produkte geschlossen und so die Qualitätsregelschleife verkürzt. Am Beispiel eines Spritzgussprozesses für schwierige Bauteile lässt sich darlegen, welche Vorgehen, welche Architekturen und Werkzeuge zum Erfolg führen.

Jeder Fertigungsprozess wird so stabil wie möglich eingerichtet, um Ausschuss und Nachprüfungen zu vermeiden. Trotzdem geht die Gleichung in vielen Fällen nicht auf. Zwar bewegen sich alle Prozessparameter innerhalb der Toleranzen, aber Nacharbeit und Verwurf kommen trotzdem immer wieder vor. Und mehr noch: Die Prozesszusammenhänge sind oft komplex und die Zahl der möglichen Einflussparameter hoch. Hier können selbst die Prozessexperten häufig nicht eindeutig klären, welche Parameter verändert werden müssen, um dem Ziel näherzukommen. Ein typisches Beispiel für solche Fertigungsszenarien ist der Spritzguss großer und transparenter oder halbtransparenter Bauteile, die ohne Transparenzfehler und mit makellosen Oberflächen gefertigt werden müssen. Manuelle Selektionsprüfungen an allen gefertigten Teilen sind in diesem Szenario kaum zu umgehen.

Daten-Akquisition und digitale Wertschöpfungskette

Soll dieser Aufwand reduziert und indirekt auf Basis der aktuellen Produktionsparameter eine automatisierte Gut-/Schlecht-Aussage getroffen werden, sind zunächst alle denkbaren Einflussgrößen zu betrachten. In erster Linie sind dies natürlich die Parameter des Spritzgussprozesses selbst, wie die verschiedenen Einspritzdrücke und Temperaturen des aufgeschmolzenen Materials in der Werkzeugform. Diese Parameter regelt jede Spritzgussanlage selbst innerhalb spezifizierter Grenzen, was aber sporadisch trotzdem zu Produktionsausschuss führt. In der Tat haben zahlreiche weitere Parameter Wechselwirkungen auf die Produktqualität. Von aktuellen Eigenschaften des eingesetzten Materials wie Feuchtegehalt und Lagertemperatur über die aktuellen Werte der Hallenklimatisierung bis hin zur Einsatzhistorie des Spritzgusswerkzeuges reicht die noch lange nicht vollständige Liste. Für einen datenbasierten Lösungsansatz ist es sinnvoll zunächst alle greifbaren Parameter – unabhängig davon, ob ihr Einfluss offensichtlich ist oder nur theoretisch vermutet wird – zu akquirieren. Neben der Erfassung von Online-Daten aus bestehenden Systemen sind hier auch viele Offline-Datenquellen relevant, beispielsweise aus Schichtbüchern, Material- und Bauteil-Bemusterungen oder Qualitätsmeldungen aus nachgelagerten Prozessen. Als nächster Verarbeitungsschritt in der digitalen Wertschöpfungskette schließt sich die automatisierte Bereinigung und Harmonisierung der erfassten Daten an. Datenspeicherung, Analysefunktionen, Entscheidungsaufbereitung und Visualisierungen für die Anwender sind weitere Schritte der Verarbeitungskette. Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

Machine Learning und Big Data

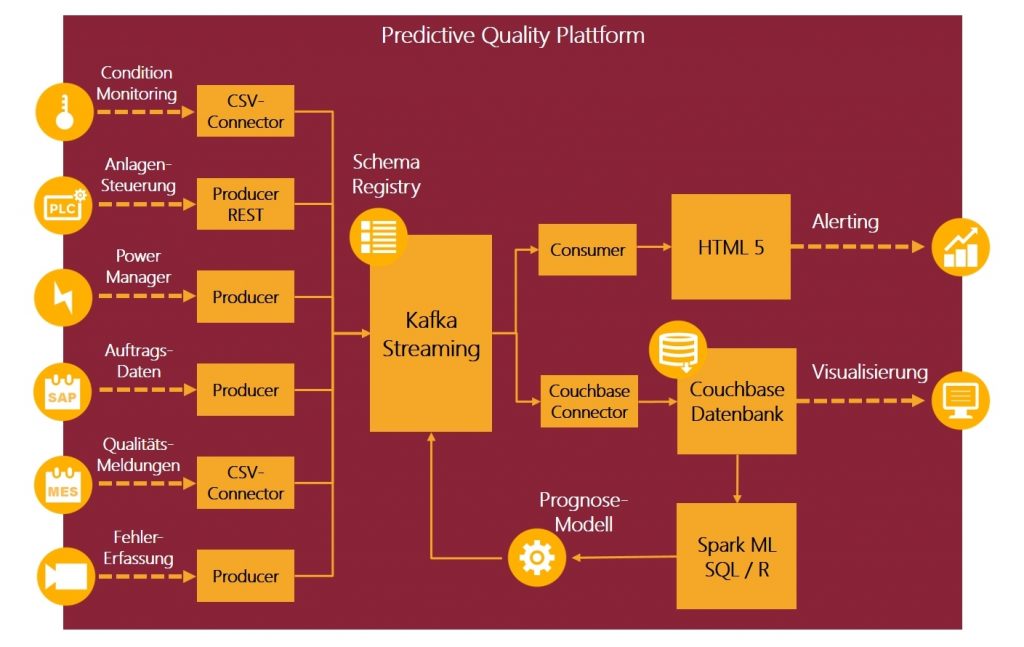

Um eine industriell einsetzbare Plattform einzurichten, muss diese Verarbeitungskette verschiedenen Kriterien genügen. Neben einem modularen Aufbau und möglichst den Verzicht auf proprietäre Software ist eine hohe Skalierbarkeit für die echtzeitnahe Verarbeitung großer Datenmengen erforderlich. Weiterhin müssen – nicht nur für dieses Beispiel der vorausschauenden Qualitätssicherung – Werkzeuge für die Erstellung valider Prognosemodelle verfügbar sein. Als technologische Plattform bietet sich das Apache Hadoop Ökosystem an, das als freie Software-Lizenz verfügbar ist. Aus diesem Ökosystem sind für den genannten Anwendungsfall nur einige Komponenten erforderlich. Als wesentlichen Baustein ist Kafka-Streaming zu nennen mit dem sich große Datenmengen in Echtzeit akquirieren und an die eigentlichen funktionalen Anwendungen weitergeben lassen. Die Daten aus den verschiedenen – in der industriellen Praxis recht heterogenen – Quellen zu bereinigen und zu harmonisieren übernehmen dabei sogenannte Producer. Die Datenweitergabe erfolgt durch Bausteine, die sich Consumer nennen. Eine Schema Registry enthält dabei stets den aktuellen semantischen Bezug zwischen den Daten. Durch diese modulare Architektur lässt sich die Plattform leicht an die Erfordernisse verschiedener Fertigungsprozesse anpassen. Das Erstellen valider Prognose-Modelle erfordert teilweise lange Betrachtungszeiträume des Produktionsgeschehens. Um Daten dafür vorzuhalten, bietet sich Couchbase an, eine NoSQL-Datenbank, die insbesondere bei den in der Produktion häufig vorkommenden langen Prozesswertreihen deutliche Performance-Vorteile bietet. Mit Spark Machine Learning, der Statistik-Sprache R und fallweise mit Hilfe von SQL-Programmierung, werden aus dieser Datenbank die Prognose-Modelle erstellt und bei Bedarf den aktuellen Produktionsprozessen angepasst. Diese Modelle finden nun ihre Anwendung in dem Echtzeitdatenstrom, sodass bei Qualitätsabweichungen Fertigungseingriffe sofort ausgelöst oder Mitarbeiter benachrichtigt werden können.

Prognose-Modelle mit Roboter und Kamera trainieren

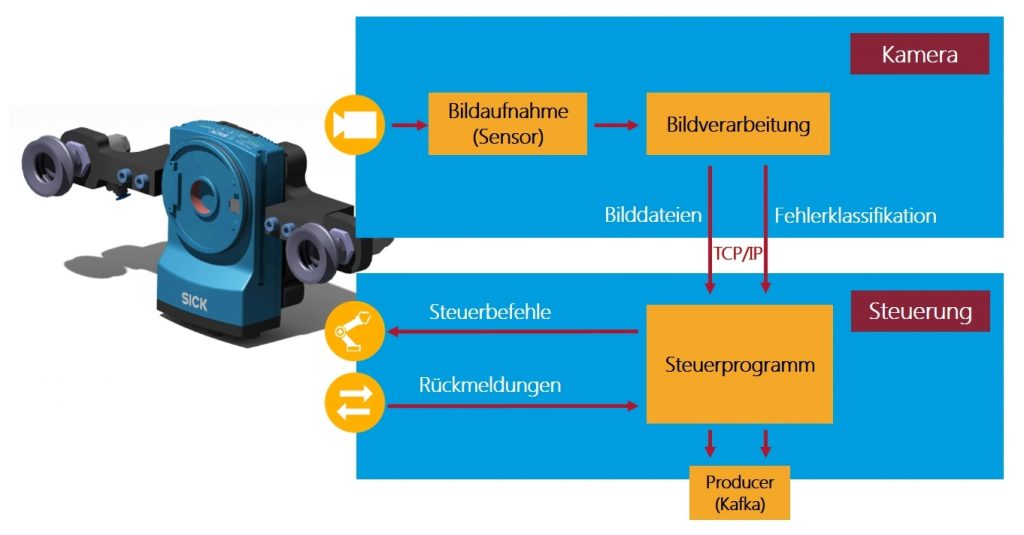

Für ein wirksames Prognose-Modell ist das anfängliche und später das korrektive Lernen der Zusammenhänge zwischen Prozess- und Betriebsdaten und den gefertigten Gutteilen sowie dem Ausschuss mit Fehlerklassifikation erforderlich. Um die manuellen Aufwände dafür zu reduzieren, bedarf es einer automatisierten Lösung für die Überprüfung der Bauteile. Dabei kann eine gleichmäßig verteilte Stichprobe aus dem Produktionsprozess ausreichen, sodass nicht im Produktionstakt geprüft werden muss. Eine Roboterprüfzelle mit Bildverarbeitungs-Applikation soll eine einfache Integration des Aufbaus in den bereits bestehenden Materialfluss ermöglichen und so zeiteffiziente Abläufe erlauben. Der Roboter erfüllt dabei die Aufgabe des Materialhandlings und -transports sowie die Positionierung und Ausrichtung der Kamera gegenüber den zu prüfenden transparenten Bauteilen. Ein spezifisch für die Anwendung entwickelter Greifer erlaubt die Aufnahme der verschiedenen Bauteiltypen und der Bildverarbeitungskamera. Eine Herausforderung hierbei ist es, den Greifer so zu gestalten, dass ein möglichst breites Typenspektrum der transparenten Bauteile gegriffen werden kann, ohne die Oberfläche der Bauteile zu beschädigen. Dazu eignet sich am besten ein mit Druckluft betriebener flexibler Sauggreifer. Der Roboter positioniert jeweils das zu prüfende Bauteil in einer dafür vorgesehenen Indexierung vor einer programmierbaren Leuchtquelle. Im Anschluss daran wird der Prüfzyklus gestartet, bei dem der Roboter eine intelligente 2D-Kamera für mehrere Aufnahmen des Bauteils führt. Hierbei unterscheiden sich die einzelnen Aufnahmen durch den Winkel zwischen Kamera und Prüfteil, wodurch unterschiedliche Fehlerarten klassifiziert werden. Die Bildverarbeitung selbst findet bereits in der intelligenten Kamera statt. Die Verarbeitung beinhaltet die Identifikation eines Fehlers auf der transparenten Oberfläche sowie – in Verbindung mit den Koordinaten des Roboters – die Lokalisierung des Fehlers auf dem Bauteil. Als Fehlerarten werden beispielsweise Kratzer, Einschlüsse und so weiter durch die Bildverarbeitungs-Software der Kamera erkannt. Nach der Überprüfung des Bauteils wird dieses vom Roboter wiederaufgenommen und an eine Position gelegt, die eine einfache Integration in den Materialfluss für die Weiterverarbeitung erlaubt. Die Steuerung des Ablaufs von Roboter, Bildverarbeitungs-Kamera und Beleuchtung erfolgt durch einen einfachen Industrie-PC. Dieser überträgt die Prüfergebnisse, zusammen mit gegebenenfalls gefundenen Fehlermarkierungen in den Originalaufnahmen der Kamera, an die Prädiktions-Plattform. Hier erfolgt die Zuordnung dieser Informationen zu den übrigen Daten des Bauteils. Auf Basis dieser Informationen wird das Modell für die Qualitätsprognose laufend verbessert. Das Manufacturing Execution System (MES) HYDRA optimiert Produktionsprozesse für Fertigungsunternehmen, um Wettbewerbsvorteile zu erzielen. ‣ weiterlesen

MES-Integrator und 360-Grad-Partner für optimierte Fertigung

Cloud-Infrastrukturen sind besonders geeignet

Die dargestellte Plattform-Architektur für die vorausschauende Qualitätssicherung kann in gleicher Form sowohl in privaten als auch in öffentlichen Cloud-Umgebungen eingesetzt werden. Für kleinere und mittlere Fertigungsunternehmen oder Einstiegsprojekte bietet sich zunächst der Betrieb bei einem externen Cloud-Anbieter an. Durch die gute Skalierung der verwendeten Komponenten bestimmen sich dabei die laufenden Kosten nur durch die Intensität der Nutzung. Für größere Industrieunternehmen ist der Einsatz einer eigenen Unternehmens-Cloud häufig kostengünstiger, insbesondere wenn mehrere Standorte die Plattform nutzen. Aus Sicherheitsgründen ist es vorteilhaft, keine direkte Verbindung zwischen dem externen Netzwerk zur Cloud und dem produktionsinternen Netzwerk mit den Datenquellen herzustellen. Dies kann durch einen Edge-Cloud-Service erfolgen, der Daten sammelt und sie bei Bedarf auch verschlüsselt. Dieser Service lässt sich so einrichten, dass Daten nur in Richtung Cloud übertragen werden können, aber keine Zugriffe von außen möglich sind. Alle Benachrichtigungen und Visualisierungen auf Basis der Daten und Prognose-Modelle werden über getrennte Anwendungen zur Verfügung gestellt. Den Produktionsmitarbeitern stehen diese dann – ja nach persönlichen Berechtigungen – in einem unternehmensspezifischen App-Store zur Verfügung.

Demonstrator auf der Hannover Messe zu sehen

Die vorgestellte Architektur wird in dem vom BMWi geförderten industriellen Verbundprojekt ‚Offene, intelligente Services für die Produktion‘ (www.openserv4p.de) entwickelt und erprobt. Dabei wurde bereits eine breit einsetzbare Big-Data-Architektur entwickelt, mit der Machine-Learning-Anwendungen nicht nur für das dargestellte Beispiel, sondern für verschiedene Aufgaben rund um prädiktive Dienste in der Produktion implementiert werden können. Neben Funktionen für die vorausschauende Qualitätssicherung stehen dabei Instandhaltungsoptimierungen und das Risikomanagement in Prozessketten im Fokus. Die industrielle Einsetzbarkeit des Konzeptes wird durch die Integration in reale Fertigungsprozesse und laufende Überprüfungen im Hinblick auf die IT-Sicherheit erreicht.

Bernhard Klimm ist Leiter der Forschungskooperationen bei Salt Solution und Jan Klöber-Koch (rechts) ist wissenschaftlicher Mitarbeiter an der Fraunhofer-Einrichtung für Gießerei-, Composite- und Verarbeitungstechnik IGCV.

Bernhard Klimm ist Leiter der Forschungskooperationen bei Salt Solution und Jan Klöber-Koch (rechts) ist wissenschaftlicher Mitarbeiter an der Fraunhofer-Einrichtung für Gießerei-, Composite- und Verarbeitungstechnik IGCV.