Kostenkontrolle beim Multi-Cloud-Betrieb

Kostenfallen bei der Cloud-Migration vermeiden

Mit ihren Digitalisierungsmaßnahmen haben Unternehmen bereits Erfahrungen gesammelt, wie sich IT-Budgetplanungen und -Kostenstrukturen mit Cloud-Umgebungen verändern können. Doch es lauern kritische Kostenfallen, die im komplexen Projektmanagement einer Cloud-Migration schnell übersehen werden können.

Eine aktuelle Studie von Harvard Business Review zeigt, dass der durch Technologie erzeugte Mehrwert von höchster Bedeutung bei Budgetplanungen ist. Allerdings vertrauen nur 62 Prozent der Befragten den im Unternehmen verfügbaren Informationen dazu. Die Hälfte gibt an, dass sie den durch Technologieinvestitionen generierten Mehrwert nur ad hoc (31 %) oder gar nicht (20 %) messen, 16 Prozent tun dies nur zu bestimmten Projektmeilensteinen. Umso wichtiger, die Kostenstrukturen offenzulegen, regelmäßig zu prüfen und zu optimieren. Dabei können folgende sechs Bereiche die Budgets einer Cloud-Migration sprengen.

On-Premise-Verbindlichkeiten

Bei der taktischen Planung, wann welche Workloads in die Cloud migriert werden sollen, stehen häufig geschäftsstrategische Kriterien im Vordergrund. Dabei werden allzu oft bestehende, dezentral verwaltete vertragliche Verpflichtungen übersehen, die mit dem bestehenden Rechenzentrum verbunden sind. Dies beginnt bei Mietverträgen und laufenden Abschreibungen der Hardware sowie deren Wartungs- und Support-Verträge, zu nennen sind zudem auch Aufwände in den Bereichen Asset Management, Administration und Audits. Wichtig ist daher, vorab anhand der Laufzeiten die Gesamtkosten solcher On-Premise-Verträge zu klären, die parallel zum Cloud-Betrieb auflaufen. Das ermöglicht eine realistische Kosten-Nutzen-Rechnung mit den nötigen Eckdaten, um ein kosteneffizientes Timing der Migration in die Cloud zu planen sowie zu entscheiden, in welchen Schritten bzw. in welcher Reihenfolge die Umstellung erfolgen sollte.

Multi-Cloud verwalten

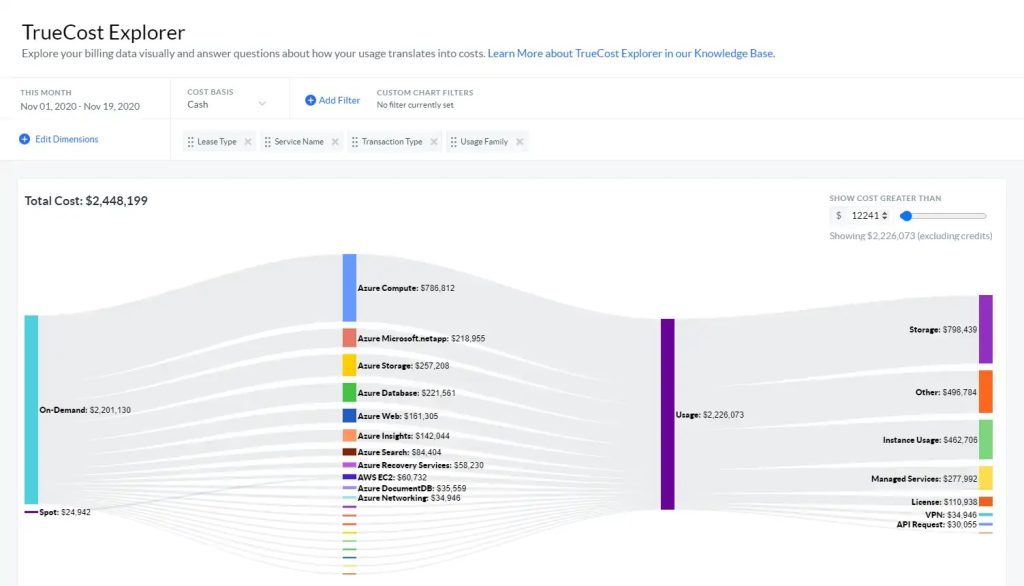

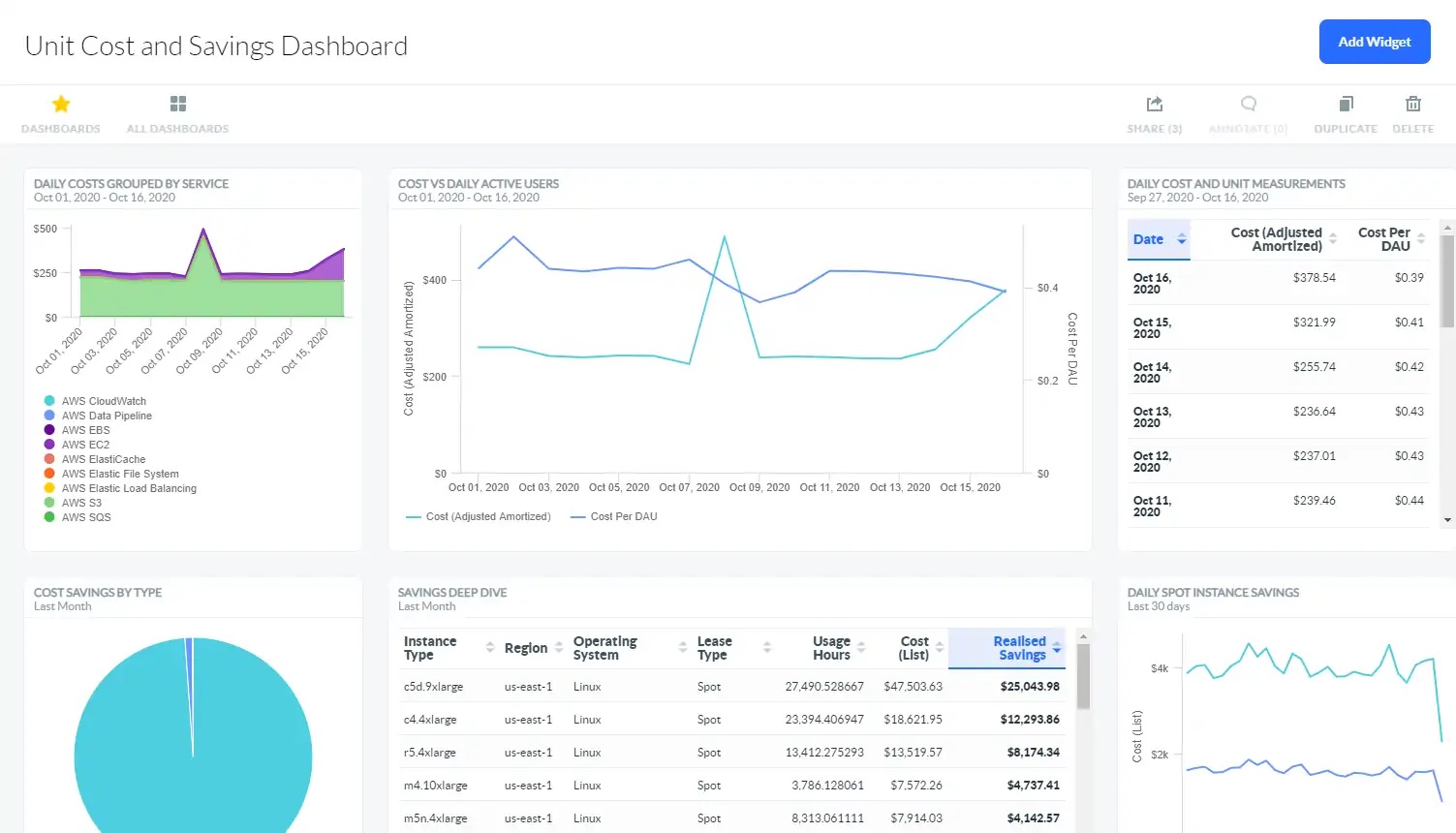

Die meisten Public-Cloud-Anbieter können aus einer Hand alle gängigen Cloud-Anforderungen erfüllen. Im Detail betrachtet variieren die Kosten und Leistungen allerdings, zudem soll die Abhängigkeit von nur einem Provider vermieden werden für eine ausgewogene Risikostreuung. Hinzu kommt, dass Multi-Cloud die Datensicherheit für Unternehmen unterstützt, indem Daten mit spezifischen Techniken codiert und über verschiedene Clouds verteilt werden für höheren Schutz vor Hackerangriffen und Datenverlusten. So sind Unternehmen beinahe zwangsläufig mit den Anforderungen eines Multi-Cloud-Managements konfrontiert. Wer darauf technisch und organisatorisch mit entsprechenden Lösungen, Experten und Prozessen vorbereitet ist, vermeidet Kostenfallen – etwa durch Workload-Analysen für bessere Prognosen, Rightsizing und die Optimierung von Kosten, die aktive Nutzung der Elastizität von Cloud-Kapazitäten für Lastspitzen oder durch Monitoring, das ungenutzte Services oder Anomalien im Verbrauch identifiziert. Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

Abrechnungsvarianten nutzen

Bei der Kostenschätzung und Budgetplanung für Cloud-Dienste ist es wesentlich zu verstehen, wie einzelne Cloud-Anbieter die Nutzung ihrer Ressourcen messen und nach welchen Kriterien abgerechnet wird – dies reicht von stundenweiser Abrechnung der Nutzung einzelner Instanzen über Kosten nach Datenmenge bis hin zum ausgehenden Datenverkehr in Gigabyte pro Monat, mit unterschiedlichen Commitments. Das heißt, Unternehmen sollten einen möglichst detaillierten Einblick dazu haben, welche Cloud-Kapazitäten in welchen Qualitäten sie über welche Zeiträume in den verschiedenen Phasen der Cloud-Migration benötigen, um die optimale Kombination an Cloud-Services beziehungsweise -Skalierung bei unterschiedlichen Anbietern zu beauftragen.

App-Performance bis Skalierung

Die Architektur und Performance von Anwendungen, was etwa den Bedarf an Arbeitsspeicher oder die Menge der Transaktionsdaten betrifft, spielt mit der zumeist großzügig dimensionierten Hardware in Rechenzentren kaum eine Rolle. Im Cloud-Betrieb kann das allerdings überraschend deutlich die Kosten in die Höhe treiben. In Multi-Cloud-Umgebungen ist es ein oft unterschätzter Kostenfaktor, wenn durch Skalierung Anwendungen über Cloud-Grenzen hinweg Datenverkehr erzeugen. Viele Cloud-Provider berechnen nach ein- und ausgehendem Traffic. Hier ist es wichtig, dass die Kostenstrukturen bekannt sind und die Anwendungen nach Lastspitzen automatisiert wieder zurück skalieren. Ähnliches gilt für Cloud-Speicher und andere Ressourcen, die beispielsweise DevOps-Teams in Projekten beanspruchen. Bei der Cloud-Migration und im Betrieb ist daher von Beginn an eine verursachergerechte Kostenanalyse hilfreich, um schnell und gezielt steuernd eingreifen zu können.

Von Lift & Shift bis zu Altsystemen

Von den vielen möglichen teuren Planänderungen bei Cloud-Migrationen sind zwei besonders hervorzuheben, die im Vorfeld durch genaue Prüfung meist vermieden werden können: Dies betrifft zunächst den beliebten Lift & Shift-Ansatz, bei dem schnell und ohne Anpassungen Anwendungen und Daten in die Cloud verschoben werden und selbst die einzelnen Cloud Services nicht auf die tatsächliche Nutzung dimensioniert wurden. Dieser vermeintlich günstige Weg kann eine unerwartete Kostenexplosion nach sich ziehen: Wenn erst im Nachhinein festgestellt wird, dass die Kosten der Public-Cloud-Infrastruktur deutlich teurer sind als die Rechenzentrums-Kosten und letztlich doch Architektur-Anpassungen für die Cloud erforderlich sind, verbunden mit erheblichem Projektierungsaufwand. Ein weiterer Kostenfaktor kann durch Altsysteme entstehen, die aus technischen Gründen nicht einfach migriert werden können, aber mit ihren Daten – zumeist aus rechtlichen Gründen – weiter vorgehalten werden müssen. Die Folge: On-Premise-Ressourcen können nicht im geplanten Maß abgeschaltet werden und belasten weiterhin IT-Budgets. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Exit-Strategie für On-Premise

In der Übergangsphase sind redundante Kapazitäten in der Cloud und im Rechenzentrum unabdingbar. Diese Phase sollte mit einem konsequenten Monitoring der Workloads und Analysen des tatsächlichen Bedarfs in Korrelation zu den Kosten und deren Variablen bei dem/den Cloud-Anbietern verbunden sein. Neben der technischen Qualität stellt dieses Vorgehen sicher, dass Entscheidungen, wann welche Rechenzentrumskapazitäten abgeschaltet werden – oder eben nicht – rasch und konsequent getroffen werden können. Ansonsten droht die Gefahr, dass teure Redundanzen unnötig lange weitergeführt werden.

Finanz- und IT-Monitoring nötig

Die Umsetzung von Cloud-Strategien ist verbunden mit einem komplexen Wechselspiel zwischen Verbrauch und Kosten, das von unterschiedlichen technischen und wirtschaftlichen Variablen geprägt ist, die sich dynamisch verändern. Es braucht daher eine zeitnahe Verknüpfung zwischen IT- und Finanz-Monitoring mit Prozessen und Systemen, die gleichzeitig zu einer Cloud-Migration implementiert werden sollten. Dies mag für manche Unternehmen zunächst ungewohnt sein, aber es hilft, den wirtschaftlichen Mehrwert aus Cloud-Initiativen zu realisieren.