Engineering mit Rechenkraft beschleunigen

Am Supercomputer simuliert

Software und Lizenzkosten

Da die einzelnen Rechenknoten eines Supercomputers jeweils über einen eigenen Speicher verfügen und die Prozesse während der Berechnung Daten austauschen müssen, werden spezielle Solver benötigt. Fast alle kommerzielle FEA- und CFD-Softwareanbieter bieten heutzutage sogenannte Distributed Memory Solver an. Die eingesetzten Routinen können jedoch variieren. So ist es möglich, dass die Software A für eine Modalanalyse eine ganz andere Parallelisierungsstrategie einsetzt als Software B. Dies resultiert in unterschiedlichen Rechenzeiten und mitunter abweichenden Ergebnisgüten. Häufig ist die konkrete Implementierung der numerischen Methoden nicht bekannt, was die Nachvollziehbarkeit und Interpretation von Ergebnissen erschwert. Ein weiteres Problem für die Akzeptanz von Supercomputern stellen die Lizenzkosten dar, denn ein Großteil der Softwareanbieter lizenzieren nach einem ressourcenbasierten Token-Modell. Besonders im Super-Computing Bereich, wo schnell einige hundert bis tausend Prozessorkerne eingesetzt werden, müssen Unternehmen eine größere Anzahl an Lizenztokens vorrätig halten, was die operativen Kosten negativ beeinflusst. Abhilfe kann der Rückgriff auf Open-Source- oder Freeware-Lösungen sein, die teilweise über sehr gute und geeignete Solver verfügen, welche jedoch häufig nicht so komfortabel zu bedienen sind. In Hinblick auf Performance und Ergebnisgüte sind diese in vielerlei Hinsicht den kommerziellen Lösungen ebenbürtig und eignen sich zudem aufgrund der meist umfangreichen Dokumentationen gut für die Automatisierung von Prozessen.

Simulationsprozesse automatisieren

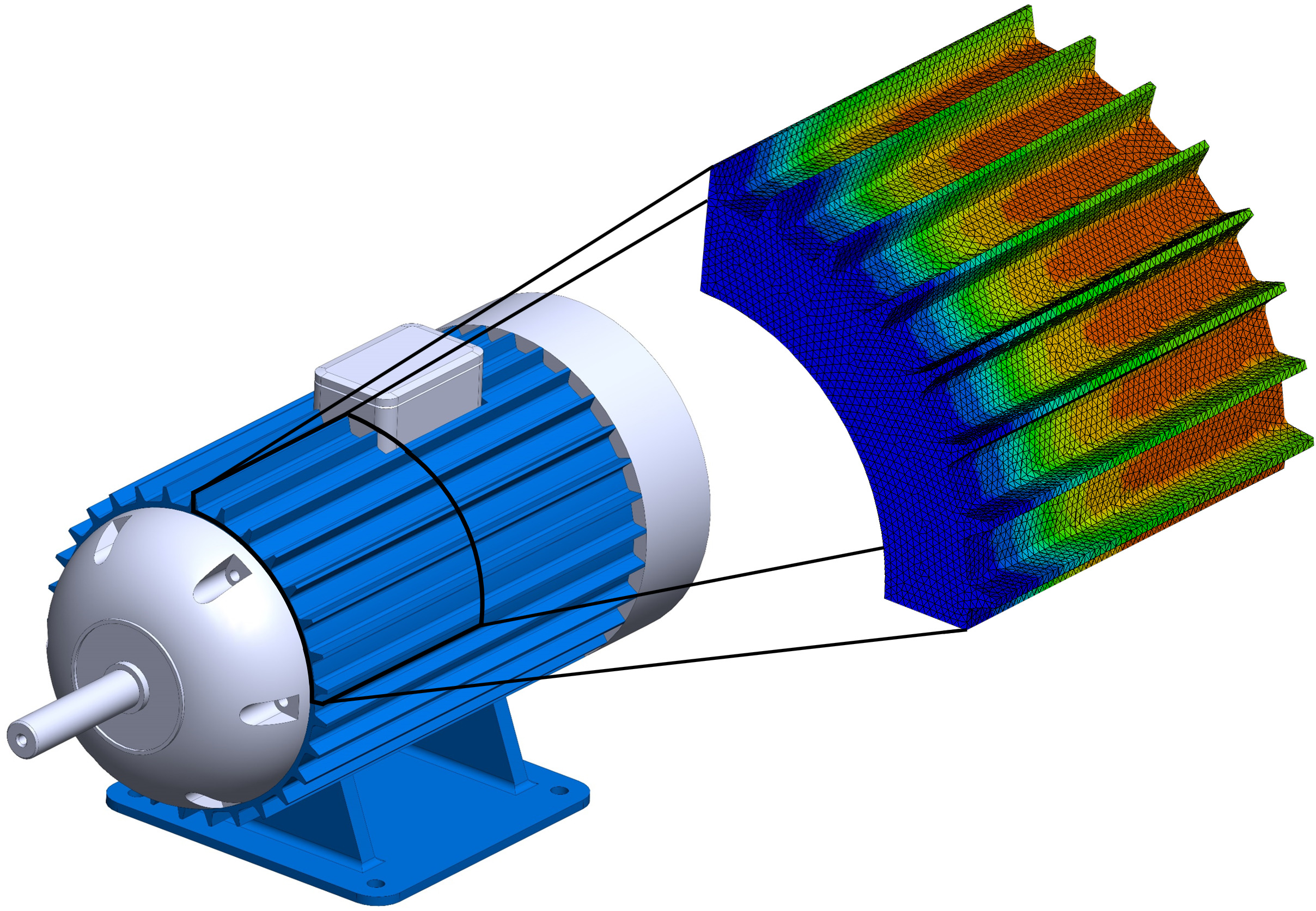

Grundlage jeder Simulation ist die Diskretisierung (Vernetzung) der zu untersuchenden Strukturen. Die Qualität der Netze beeinflusst Ergebnisgüte und Rechendauer entscheidend: Je feiner das Netz, desto größer ist das mathematische Problem und desto länger sind die Rechenzeiten. Die Entwicklung der Distributed Memory Solver konzentriert sich größtenteils auf das schnelle Lösen der Gleichungssysteme. Mit immer größer und detaillierteren Strukturen steigt aber auch Aufwand auf Seiten der Netzgenerierung. Und dieser Prozessschritt lässt sich schwer auf Supercomputer auslagern, da die Beurteilung der Netzqualität (und damit der Vertrauenswürdigkeit der Ergebnisse) eine maßgeblich kognitive Aufgabe des Ingenieurs ist. Eine automatische Tetraeder-Vernetzung in Kombination mit Qualitätsparametern zur Steuerung des Prozesses ist zwar möglich, der Erfahrung nach jedoch schwierig umzusetzen, da ‚feiner‘ nicht grundsätzlich ‚besser‘ bedeutet. Wie Untersuchungen im Projekt zeigten, streuen die Abweichungen der numerischen zu den exakt berechneten Spannungen stark und nicht nur bei den groben Netzen. Daher wird im Projekt intensiv mit dem Partner LeoSim Technologies zusammen daran geforscht, automatisierte und robuste Vernetzungsprozesse zu realisieren.

Herausforderung Datentransfer

Stand heute ist weiterhin zu empfehlen, die Netzgüte vor Berechnungsbeginn zu prüfen und sich nicht auf die Ergebnisse der automatischen Vernetzter zu verlassen. Der damit verbundene Medienbruch führt zu aufwendigen Datenübertragungsprozessen vom Supercomputern auf die Arbeitsplätze der Anwender. Da es sich meist um erhebliche Datenmengen handelt, belastet das die Firmennetzwerke und verhindert durch die Wartezeiten auch ein wirtschaftliches Arbeiten, sofern sich die Daten überhaupt verarbeiten oder visualisiert lassen. Gerade Unternehmen ohne Breitband-Anbindung trifft dieses Problem schwer. Als Best Practice hat sich in Bayreuth die Installation eines Terminalservers im Netzwerk des Supercomputers etabliert. Durch die Bereitstellung des virtuellen Desktops können Pre- und Postprocessing seitens der Praxispartner ausgelagert werden. Der Großteil der Daten bleibt im Netzwerk des Supercomputers und der Datentransfer zum Anwender beschränkt sich auf den Fernzugriff, etwa über eine VPN-gesicherte oder eine RDP-Verbindung.