Sicherheit autonomer Systeme

Roboter vor Manipulation schützen

Autonome Roboter bieten Cyberkriminellen neue Angriffsflächen. Verschaffen sie sich Zugriff, könnten sie etwa Parameter minimal ändern, was sich negativ auf die Produktqualität auswirkt. Die Plattform Lernende Systeme beschreibt in einem Whitepaper, wie sich das verhindern lässt.

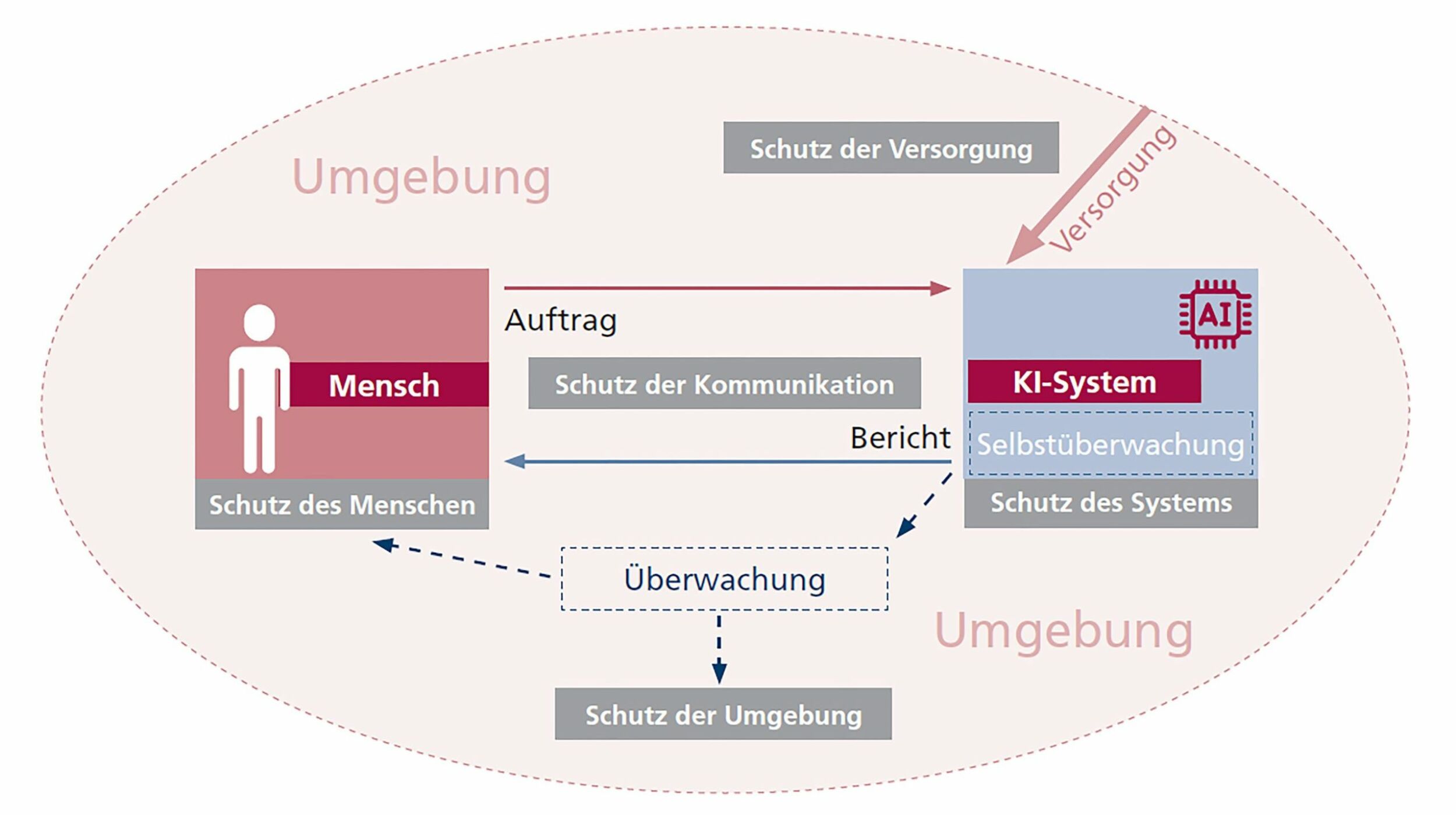

Ob zur Inspektion von Ölplattformen, zur Überwachung von Industrieanlagen oder zur Dokumentation auf dem Bau – autonome, mobile Roboter kommen bereits vielerorts zum Einsatz. Nicht zuletzt die Fortschritte auf dem Gebiet des maschinellen Lernens und dabei insbesondere beim maschinellen Sehen haben diese Entwicklung in der Robotik ermöglicht. Sie können etwa Industrieanlagen oder Baustellen vermessen, Messstände ablesen und die Informationen zur weiteren Auswertung zur Verfügung stellen. Autonome Systeme bieten aber auch Kriminellen eine Angriffsfläche. Ein System kann entgegen dessen eigentlichen Zweck genutzt werden und so etwa körperliche und psychische Unversehrtheit von Menschen, gefährden oder immaterielle Werte verletzen und der Umwelt schaden. So können Roboter als Waffe oder für Sabotage- oder Spionageakte zweckentfremdet werden. Doch die Automaten können gegen solch missbräuchliche Nutzung gewappnet werden. In ihrem Whitepaper ‚KI-Systeme schützen, Missbrauch verhindern‘ geben Expertinnen und Experten der Plattform Lernende Systeme Empfehlungen. Gerade bei autonomen Systemen können beispielsweise die frühzeitige Erkennung von Anomalien sowie die Einschränkung bestimmter Funktionalitäten des Systems besonders wichtig sein.

Anomalien erkennen

Diese Anomalien können mithilfe künstlicher Intelligenz ausfindig gemacht werden. Es handelt sich um Abweichungen vom Umgebungsmodell beim autonomen Fahren oder Abweichungen vom geplanten Verlauf eines Einsatzes. Handlungen ähnlicher KI-Systeme können dazu beispielsweise in einer Cloudumgebung gesammelt werden. Auf diese Weise könnte abgeglichen werden, ob diese Handlungen bereits in ähnlichen Situationen vorkamen. Verdächtige oder ungewöhnliche Anfragen und Handlungen könnten so ermittelt und geprüft werden – etwa durch Simulationen, die erwartete Ergebnisse, wie System- oder Umweltveränderungen, analysieren. Die gesammelten Daten können wiederum in Lernprozesse überführt werden, um die Anomalieerkennung weiter zu optimieren. Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

Funktionen einschränken

Die Funktionalitäten und Fähigkeiten von autonomen Robotern können für bestimmte Orte, Zeitfenster, Situationen und Umgebungen deaktiviert bzw. der Grad der Autonomie reduziert werden. Beispiele dafür sind das Geofencing und -targeting. Dabei werden anhand geographischer Koordinaten Funktionen auf einem bestimmten Gebiet beschränkt. Die Fähigkeiten von KI-basierten, mobilen Robotern können auch gekoppelt an eine Umgebungsanalyse auf Basis der Sensoren des Roboters eingeschränkt werden. Das heißt, dass bestimmte Fähigkeiten nur dann freigegeben sind, wenn Sensoren spezifische Merkmale eines Ortes oder einer Umgebung erkennen. Solche Umgebungs- und Ortsanalysen stellen eine Alternative oder Ergänzung dar, da Verfahren wie Geofencing und -targeting technisch umgangen werden können. Die Grundlage dafür kann der Abgleich von Informationen aus unterschiedlichen Sensoren eines mobilen KI-Systems bilden.

Zwei Szenarien

Szenario 1 – Anomalie-Erkennung und Funktionalitätseinschränkung bei einem autonomen Bagger: Auf einer Baustelle soll ein autonomer Bagger eingesetzt werden, der selbstständig eine festgelegte Aufgabe abarbeitet. Terroristischen Cyberkriminellen gelingt es, über eine Sicherheitslücke Zugriff auf das System des Baggers zu erhalten und sie versuchen diesen auf die nahe Autobahn zu lenken. Bewegt sich der Bagger auf das Ende der abgegrenzten Baustelle zu, wird ein Überschreiten der Begrenzung durch ein zertifiziertes vom Hauptsystem abgekapseltes System zur Anomalie- und Umgebungserkennung verhindert. Das System deaktiviert den Bagger und sendet es eine Anfrage an die Zentrale zur Überprüfung sowie gegebenenfalls zur manuellen Kontrollübernahme via Teleoperation. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Szenario 2 – Anomalie-Erkennung und Bewegungskorrektur bei Roboterarmen in Industrieanlagen: Cyberkriminelle werden damit beauftragt einem Unternehmen ökonomischen Schaden zuzufügen. Sie nutzen eine Sicherheitslücke und übernehmen einen oder mehrere Roboterarme in einer Produktionsstraße für einen Sabotageakt. Ihr Ziel ist es, die Routinen der Arme minimal abzuändern, so dass die Schäden an den Produkten nicht sofort sichtbar sind. Die vorangegangenen Routinen des Roboters wurden jedoch in eine abgesicherte Datenbank überführt, um damit die Anomalie-Erkennung zu trainieren. Selbst minimale Abweichungen werden in der Folge erkannt und die Werksleitung benachrichtigt. Ein vom Hauptsystem abgekapselter und zertifizierter Regelsatz wird zugleich automatisch aktiviert, der Roboterarm wird umgehend wieder in die ‚gewohnte‘ und gelernte Routine überführt.

Schutz mitdenken

Robotikanwendungen werden in den nächsten Jahren in viele Branchen und Bereichen der Gesellschaft vermehrt eingesetzt werden. Neben technischen Fortschritten ist der Grund hierfür auch, dass Robotik in den vergangenen Jahren immer kostengünstiger geworden ist, wie etwa der diesjährige Standford AI Index betont. Parallel zur Verbreitung von Robotik sollte auch der Schutz vor Missbrauch mitbedacht werden. So können bei der (Weiter-)Entwicklung solcher Systeme mögliche Missbrauchsziele und Gegenmaßnahmen abgeleitet werden, die als Prävention implementiert oder im Ernstfall umgesetzt werden können. Zudem könnte die Forschung zum Schutz vor Missbrauch ausgebaut werden. Ziel sollte es sein, das Vertrauen in den Einsatz autonomer, mobiler Robotik zu stärken, um die wirtschaftlichen und gesellschaftlichen Potenziale freizusetzen.