Deterministisches Verhalten in Multicore-Edge-Systemen

Die einsatzkritische Netzwerkperipherie

In der vertikalen Industrieautomatisierung herrscht weitgehend Einigkeit darüber, dass sich der Einsatz moderner Rechenressourcen mit Cloud-nativen Modellen des Software-Lifecycle-Managements immer mehr durchsetzen wird. Mit dem Prinzip Mission-Critical-Edge lassen sich dabei besonders die Herausforderungen an der Schnittstelle zwischen Embedded-Technologie und Informationstechnologie angehen.

In den Anwendungen für die Fabrikvernetzung existiert Edge Computing vor allem, um Eigenschaften und Anforderungen zu erfüllen, die Cloud-native Paradigmen nicht abdecken können. Dazu zählen insbesondere diejenigen, die in den unteren OT-fokussierten Ebenen der industriellen Pyramide benötigt werden:

Heterogene Hardware – Typische industrielle Automatisierungsumgebungen haben unterschiedliche Architekturen, x86, Arm, sowie eine Vielzahl von Rechen-Konfigurationen.

Sicherheit – Die Sicherheitsanforderungen und deren Abmilderungen sind von Gerät zu Gerät unterschiedlich und müssen sorgfältig gehandhabt werden.

Innovation – Während einige industrielle Anwendungen mit dem alten Paradigma weitermachen können, das seit über einem Jahrzehnt gleich geblieben ist, erfordert der Großteil der industriellen Welt nun zusätzlich moderne Datenanalyse und Überwachung der Anwendungen in ihren Anlagen.

Datenschutz – Wie in anderen Bereichen der IT wird die Verwaltung von Datenberechtigungen in vernetzten Maschinen immer komplexer und muss bereits bei der Entstehung der Daten geregelt werden.

Echtzeit und Determinismus – Der von Steuerungen bereitgestellte Echtzeit-Determinismus bleibt für die Sicherheit des Betriebs entscheidend.

Kritische Anwendungen

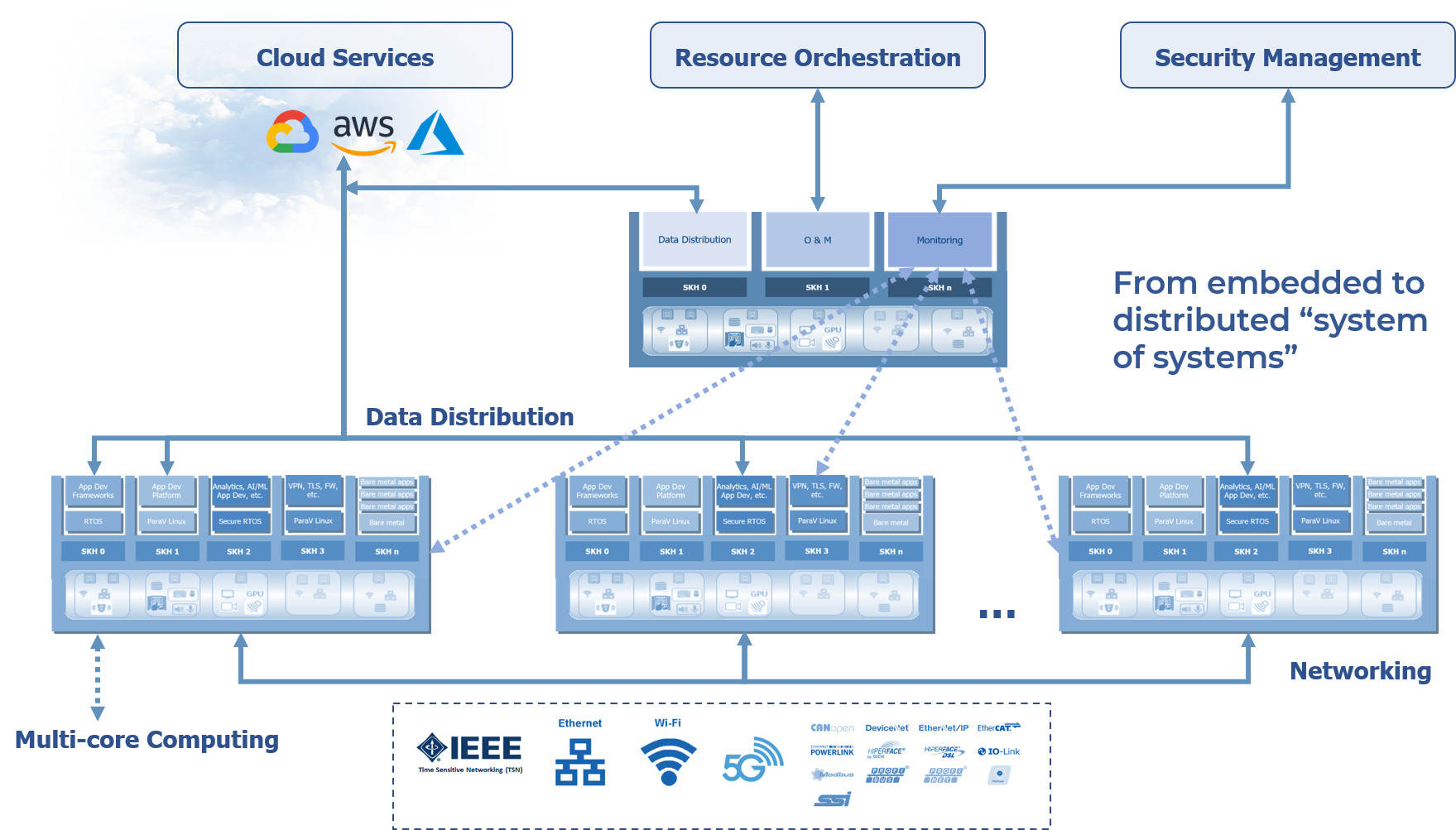

Im nachfolgend beschriebenen Mission Critical Edge-Konzept wurden Anforderungen gestellt, die typisch für Embedded Computing sind (Sicherheit, Echtzeit und sicheres, deterministisches Verhalten) und in ein Szenario für vernetztes, virtualisiertes, containerisiertes Softwarelifecycle-Management versetzt. Es geht die Herausforderungen der IT/OT-Schnittstelle an, indem es wesentliche, aber fragmentierte Legacy-Systeme durch technologische Möglichkeiten wie Datenanalyse und künstliche Intelligenz (KI) ergänzt. Die in Abbildung 1 dargestellte Architektur würde Folgendes bieten: Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

Verteilte und zusammengeschaltete, gemischtkritische, virtualisierte Multicore-Rechenknoten (System of Systems).

Netzwerkunterstützung für IT-Kommunikation und deterministische Legacy-Feldbusse, die sich in Richtung eines verbesserten Determinismus durch IEEE Time Sensitive Networking (TSN) bewegen, sowie öffentliche und private 4G/5G.

Unterstützung für die Datenverteilung innerhalb und zwischen den Knoten, basierend auf Standard-Middleware (OPC UA, MQTT, DDS und mehr) wird auch Determinismus anstreben (OPC UA über TSN).

Als virtuelle Maschinen und Container verpackte Anwendungen.

Im industriellen Testfeld

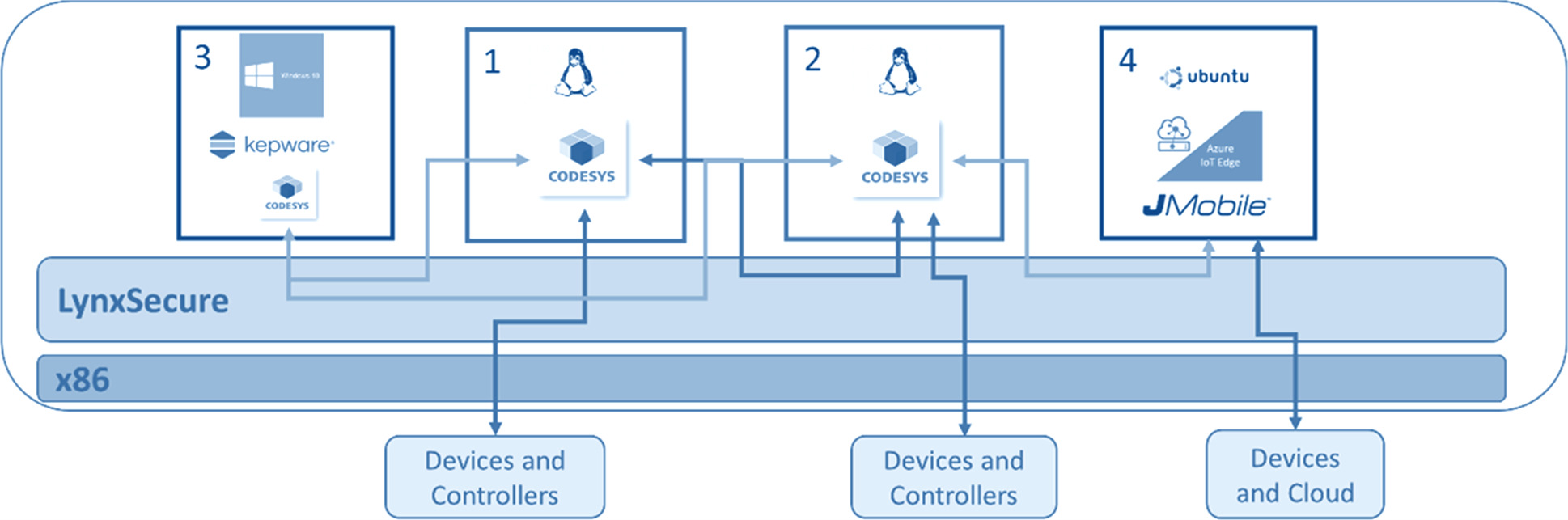

Mit diesem Zielbild haben die Firmen Codesys, Exor, Lynx, und Next Stel ein industrielles Testbed errichtet. Wie in Abbildung 2 dargestellt, wurde LynxSecure mit vier Gästen konfiguriert. Damit diese Konfiguration funktioniert, muss sich die Systemperformance auf dem anspruchsvollen Niveau der Betriebstechnik bewegen. Das hängt vor allem von der Leistungsfähigkeit der virtualisierten Anwendungen ab.

Erste Testergebnisse

Da eine typische industrielle Steuerung auf einer zyklischen Regelung basiert, muss ein Steuerungssystem sicherstellen, alle Berechnungen an den Endpunkten des Regelkreises und alle in jedem Regelzyklus erforderlichen Kommunikationen zwischen diesen Punkten vor Beginn des nächsten Zyklus abgeschlossen sind. Dafür wurden im Testbed drei Messreihen durchgeführt – mit Codesys, das auf Bare-Metal-Hardware läuft, mit Codesys, das auf LynxSecure läuft, und schließlich mit Codesys, das auf LynxSecure mit störenden Workloads läuft. In allen drei Fällen wurde die Codesys-Kontaktplananwendung mit einer Zykluszeit von 250 µs (Mikrosekunden) betrieben. Es gab nur eine sehr geringe Verschlechterung der Echtzeit-Performance, wenn die Codesys-Anwendung von der Bare-Metal- auf die LynxSecure-Umgebung migriert wird, und keine nennenswerte Verschlechterung der Echtzeit-Performance der Codesys-Anwendung, die auf LynxSecure läuft, mit oder ohne störenden Workloads. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Die Echtzeit-Leistungsanalyse

Angesichts dieser Ergebnisse testete Next-Stel Solutions die Leistung noch gründlicher, um zu bewerten, wie die gewählte Architektur den Echtzeit-Netzwerkverkehr bewältigen würde. In einer umfangreichen Analyse unter Berücksichtigung von Jitter, Scheduling-Latenz und Netzwerk-Stack-Latenz ergab die Studie, dass der LynxSecure-Hypervisor kritische Echtzeit-Aktivitäten effektiv von anderen Aktivitäten isoliert, die auf demselben System gehostet werden, und fügte gleichzeitig bis zu 50 Mikrosekunden zu dem Jitter hinzu, der im Vergleichsaufbau, aber ohne Virtualisierung, beobachtet wurde. Es wurde gefolgert, dass die minimale Zykluszeit, die mit dieser Lösung gehandhabt werden kann, 250 Mikrosekunden sowohl für EtherCAT als auch für Profinet beträgt. Noch schnellere Zykluszeiten sind wahrscheinlich möglich, wenn Para-Virtualisierung oder ein anderes RTOS als Debian RT eingesetzt wird.

Der Praxistransfer

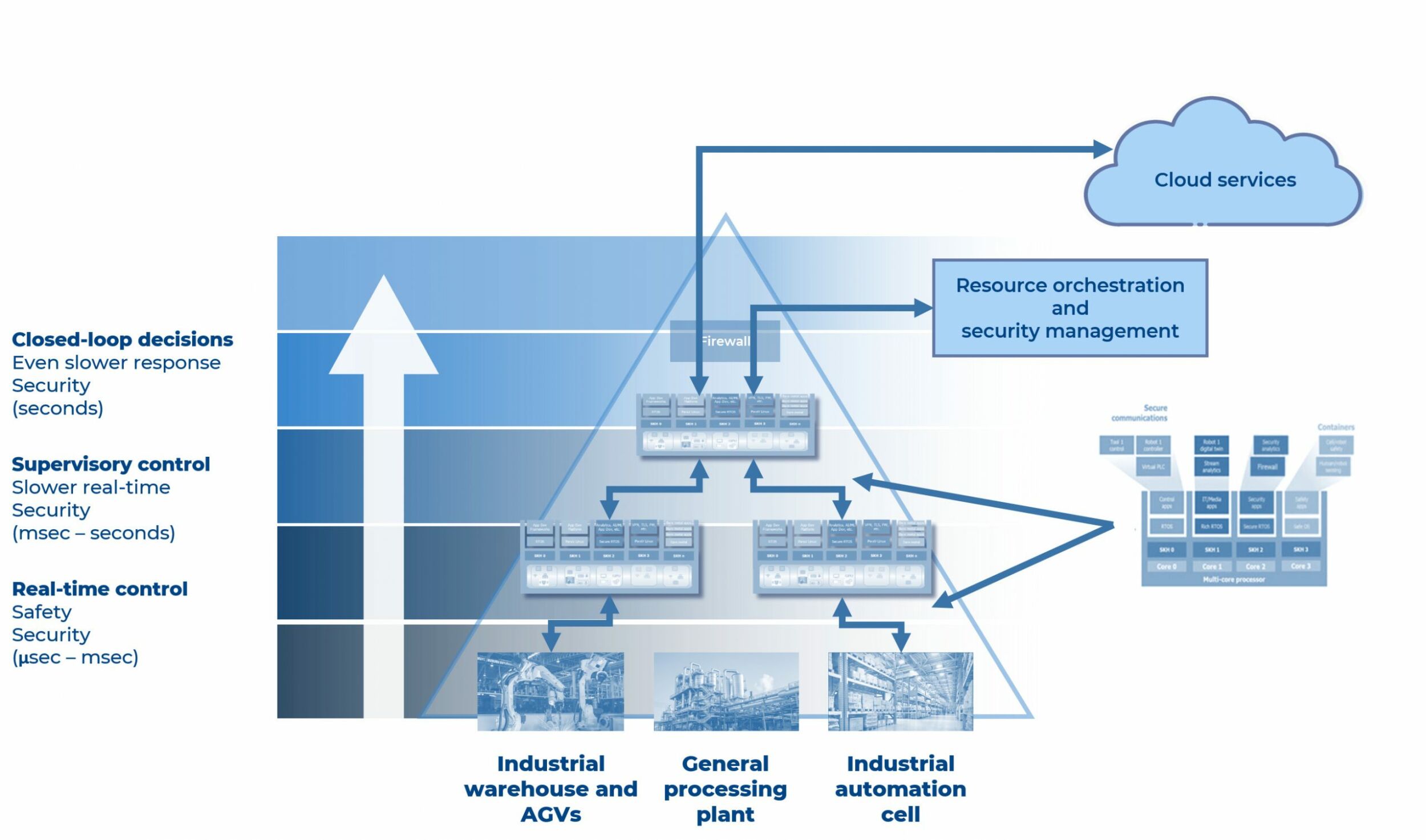

Diese Ergebnisse legen nahe, dass Edge-Computung-Systeme durchaus in der Lage sind, die klassischen Aufgaben an der IT/OT-Schnittstelle zu bewältigen und gleichzeitig die von OT-Anwendungen geforderte deterministische Echtzeitleistung bereitzuhalten. Die Sicherheitsprobleme, die durch die Verschmelzung beider Systemwelten entstehen, lassen sich wie gehabt durch Domänentrennung und Least-Privilege-Prinzipien lösen. Abbildung 3 schematisiert eine Infrastruktur am missionskritischen Rand, eingebettet in die Betriebstechik einer Fabrik. Es gibt eine verteilte Menge von Knoten, einige ganz in der Nähe der Anlage, einige weit entfernt. Im Endeffekt ist dies wie ein verteiltes Rechenzentrum, enthält jedoch einen weitaus heterogeneren, miteinander verbundenen, virtualisierten Satz von Rechenressourcen, die die Anwendungen dort hosten können, wo und wann sie benötigt werden. Diese werden in Form von virtuellen Maschinen und Containern bereitgestellt, die aus der Cloud oder lokal orchestriert werden. Deterministisches Verhalten in den Systemen ermöglicht es dabei, Anwendungen auf einzelne Multicore-Prozessoren zu konsolidieren, ohne das Verhalten zeitkritischer Funktionen zu beeinträchtigen.