Werksnahe IT-Infrastruktur

Wenn der Rand ins Zentrum rückt

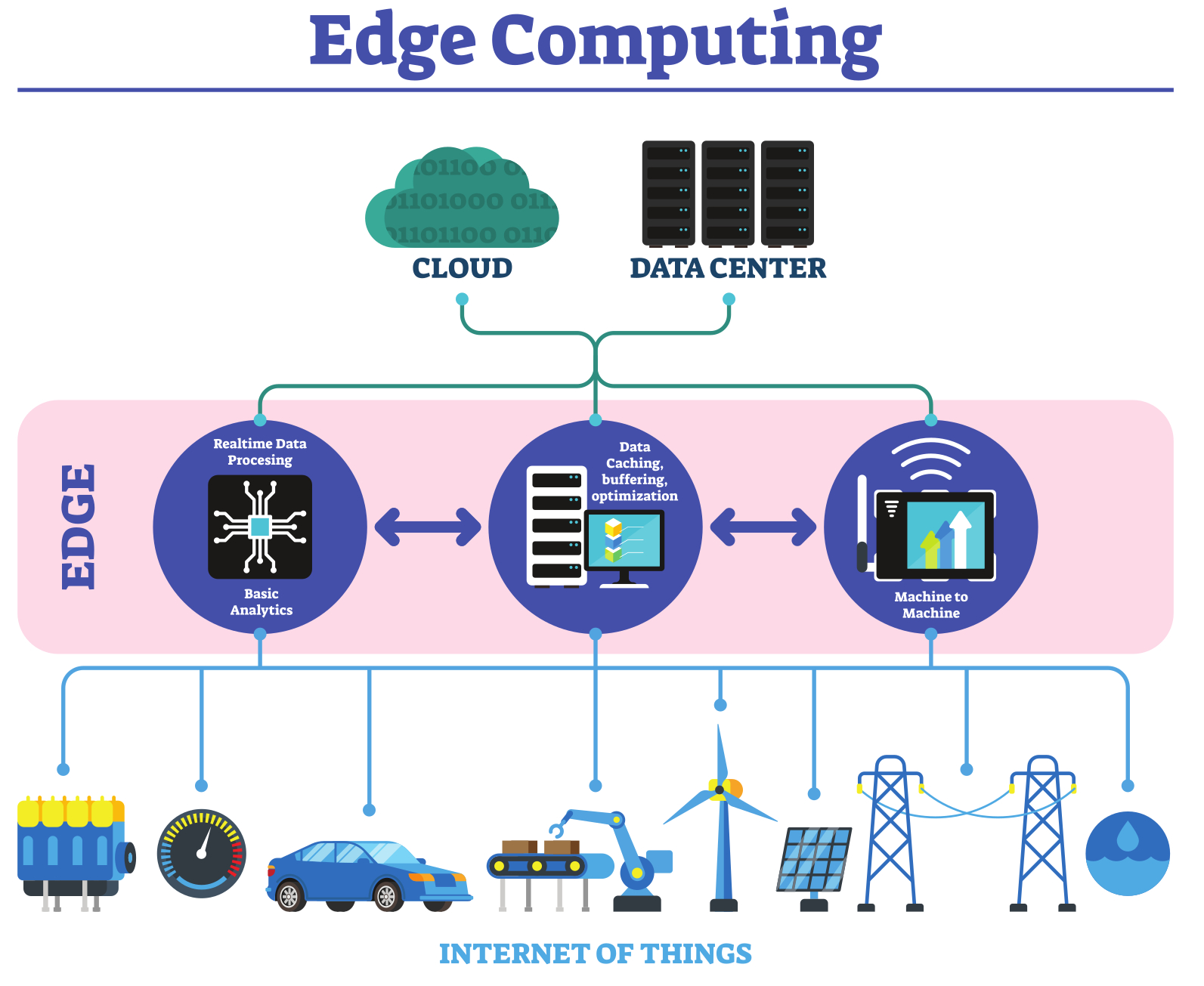

In der Produktion werden die Daten der Maschinen am Rande des Netzwerks gesammelt und dort auch verarbeitet. Doch wie sieht eine Infrastruktur aus, in der sich Edge Computing auszahlt? Denn es gilt, Stolpersteine bei Schnittstellen, Performance, Netzwerktechnik, Datenrelevanz und Erkenntnisgewinn zu umgehen.

Die Digitalisierung von Zustands- und Prozessdaten von Maschinen und Anlagen bietet für Fertigungsunternehmen zahlreiche Vorteile. Daraus ermittelte Erkenntnisse können die Produktivität steigern und Kosten senken. So lässt sich etwa Ausschuss vermeiden, wenn eine fehlerhafte Charge bereits vor der Verarbeitung erkannt und sofort entfernt wird. Vorausschauende Wartung überwacht automatisch Verschleißteile und plant den Austausch zu einem geeigneten Zeitpunkt im Produktionsablauf.

Geschäftskritische Prozesse

Diese Anwendungsfälle benötigen jedoch eine zuverlässige und oft schnelle Bereitstellung und Auswertung der Maschinendaten. Denn es handelt sich hier oft um geschäftskritische Prozesse. Das bedeutet, die Auswertung der Maschinendaten am Rande des Netzwerks, an der sogenannten Edge, erfordert eine leistungsfähige und ausfallsichere Infrastruktur. Dabei gilt es, unter anderem folgende Apspekte zu beachten:

- • die Anbindung der Maschinen an das Datennetz der Firma,

- • die Auslegung der unternehmenseigenen Netzwerk- und Rechenzentrums-Infrastruktur für geschäfts- oder unternehmenskritische Anwendungen,

- • die Entscheidung für Edge-, Cloud- oder Hybrid-Cloud-basierte Datenverarbeitung,

- • die Interpretation der Daten zur gewünschten Prozessverbesserung.

Maschinen anbinden

Die rein technische Anbindung von Maschinen und Geräten an die IT-Welt stellt heute kein großes Problem mehr dar. Dazu gibt es Gateways, die entweder die SPS der Maschine oder einzelne Sensoren oder Messgeräte anschließen und die Daten in das Firmennetz übertragen. Neuere Maschinen besitzen dafür oft Standardschnittstellen wie OPC UA. Ältere Geräte lassen sich meist über Adapter oder Konvertierungen einbinden. Allerdings können in beiden Fällen in der Praxis Herausforderungen auftreten. So kann es zu Einschränkungen der Performance aufgrund der Schnittstellen kommen.

IT-Infrastruktur optimieren

Sind die Maschinen angebunden, senden sie eine große Menge an Zustands- und Prozessdaten in das Firmennetzwerk. Je nach vorhandener Bandbreite und Verarbeitungsgeschwindigkeit kann dies die bestehende IT-Infrastruktur überfordern. Es dürfen jedoch im Datentransfer keine Verzögerungen oder gar Unterbrechungen auftreten, wenn die Anlagen permanent zu überwachen sind. Denn der aktuelle Status muss jederzeit bekannt sein, um im Notfall schnell in die Prozesssteuerung eingreifen zu können. Aus diesem Grund lohnt es sich häufig, einen externen Spezialisten das aktuelle Unternehmensnetz und die bestehende RZ-Infrastruktur auditieren zu lassen. Auf Basis der Schwachstellenanalyse lässt sich die Infrastruktur effizient verbessern oder – wenn nötig – an bestimmten Stellen erneuern.

Sicherer durch Segmentierung

Zur Optimierung bietet es sich an, die IT-Infrastruktur für die Maschinendaten weitgehend von der Büro- und Mitarbeiterebene zu trennen, was die Datensicherheit im Maschinennetz erhöht. Nun gilt es zu klären, welche grundlegende Übertragungstechnik in Frage kommt: leitungsgebunden, WiFi oder 5G. Ein leitungsgebundenes Kupfer- oder Glasfasernetz ist sehr performant in der Datenübertragung, dafür aber ortsgebunden und relativ unflexibel, wenn zusätzliche Sensoren oder Geräte anzubinden sind. WiFi und 5G bieten als Funkstandards eine höhere Flexibilität und weitgehende Ortsunabhängigkeit. Im Vergleich ist WiFi oft günstiger und einfacher zu implementieren, da keine Lizenzgebühren anfallen und mehr Geräte zur Auswahl stehen. 5G ermöglicht dagegen höhere Übertragungsraten, eine niedrigere Latenz von unter drei Millisekunden und größere Flexibilität ohne Verkabelungsaufwand. Dem stehen jedoch gewisse Investitionskosten und Lizenzgebühren gegenüber. Zudem sind Einrichtung und Management eines privaten 5G-Netzwerks nicht trivial und sollten gemeinsam mit dem Telekommunikationsanbieter und Lösungspartnern erfolgen. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Edge und Cloud kombinieren

Bei der Entscheidung für die passende Technik ist auch der Ort der Datenverarbeitung wichtig. Sollten die Analysen möglichst nahe an der Maschine – also in der Edge – oder Cloud-basiert erfolgen? Entstehen im laufenden Betrieb sehr viele Daten, ist es sinnvoll, nicht alle Maschinendaten in die Cloud zu senden. Dies kann zu einer Überlastung des Netzes, langen Antwortzeiten, hohen Kosten für die Datenübertragung und Beeinträchtigungen durch mögliche Störungen der Internet-Verbindung führen. Für die Verarbeitung am Netzwerkrand wird jedoch eine Edge-Computing-Infrastruktur benötigt – also lokale Rechen- und Speicherkapazitäten. Da an einem Standort nur die Daten weniger Sensoren auszuwerten sind, reichen jeweils begrenzte Ressourcen aus, wie etwa Mini- oder Micro-Datacenter (MDC) von Dätwyler IT Infra. Sie sind klein dimensioniert und umfassen ein oder mehrere Racks mit einer Leistung von je 1 bis 7kW. Die Racks sind drahtlos oder über Kabel direkt mit den Geräten verbunden.

Cloudverbindung herstellen

Nachdem die Daten in der Edge voranalysiert wurden, können zusammengefasste Informationen in die Cloud gesendet werden. Dort erfolgen dann übergeordnete Auswertungen, etwa für Berichte, Benchmarks und Trends. Alarmmeldungen oder wichtige Benachrichtigungen hingegen sollten direkt an die Verantwortlichen geschickt werden. Je nach Anwendungsfall und Priorität geht es darum, Edge- und Cloud-Computing sowie direkte Meldungen auf optimale Weise zu kombinieren.

Daten interpretieren

Häufig unterschätzt wird der letzte Schritt: die richtige Interpretation der analysierten Daten. Denn die Ergebnisse sollten zu echten Prozessverbesserungen führen. Zum Beispiel reicht es nicht, eine immer wieder auftretende Abweichung eines hergestellten Produktes zu korrigieren. Stattdessen sollte die Ursache für diesen Fehler ermittelt und behoben werden. Dazu lassen sich die Daten aus dem Maschinenverbund bei Bedarf mit Umgebungsdaten wie Hallentemperatur und Luftfeuchtigkeit analysieren – durch Experten und gegebenenfalls KI-unterstützt. So können produzierende Unternehmen nicht nur Zusammenhänge erkennen, sondern auch weitere Möglichkeiten zur Effizienzsteigerung und Kostenreduktion entdecken und verwirklichen.