Sprint zum Machine Vision-Prototyp

Vier Anwendungen für eine Trägerplatine

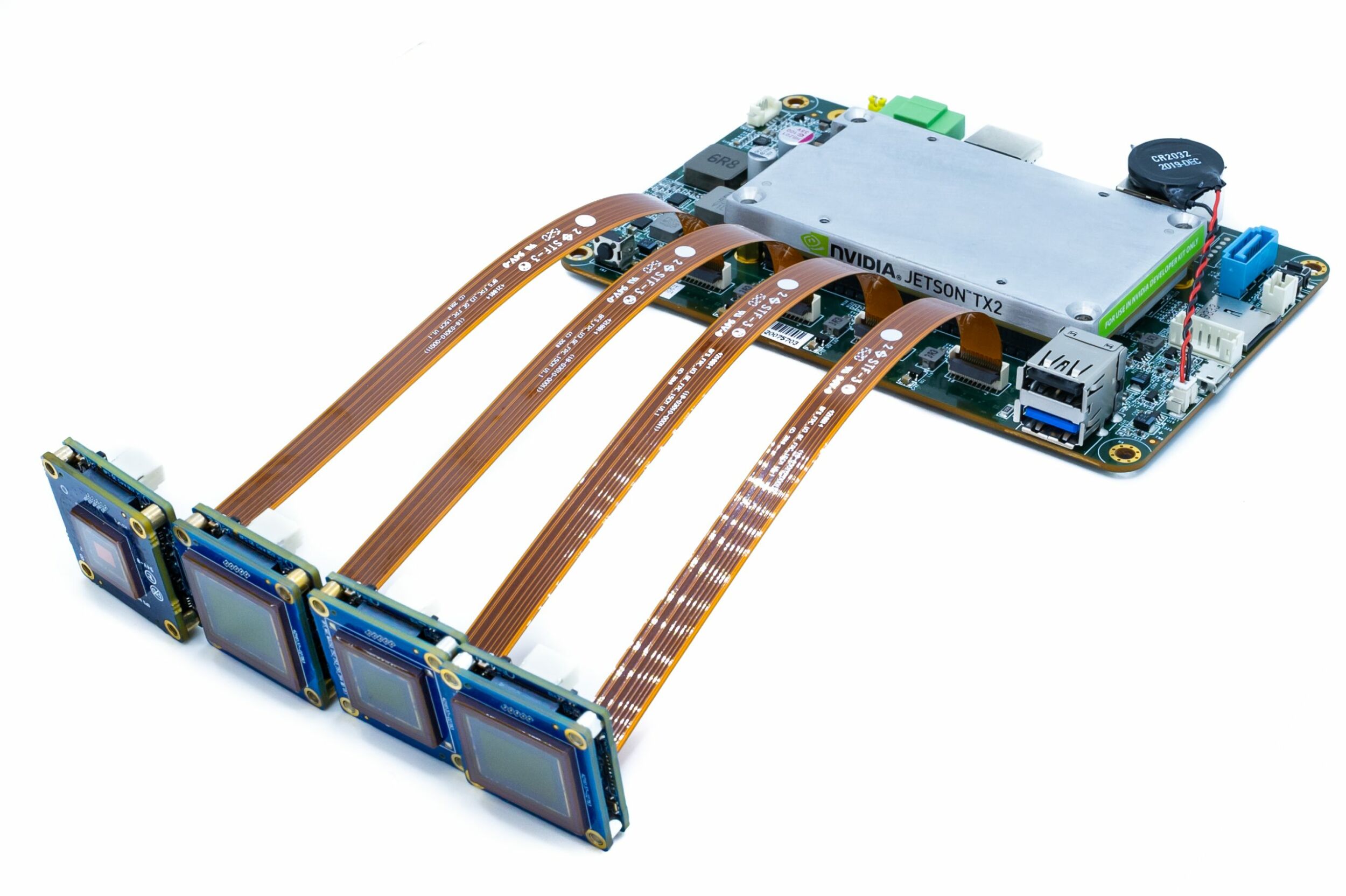

Neben der Rechenleistung sind bei Embedded-Vision-Lösungen oft kompakte Maße gefragt. Um Anwendern ein kompaktes Setting und schnelle Prototypen zu ermöglichen, hat Teledyne FLIR einen Quartettträger mit TX2-Modul vorgestellt. Vier Beispiele illustrieren die Einsatzmöglichkeiten.

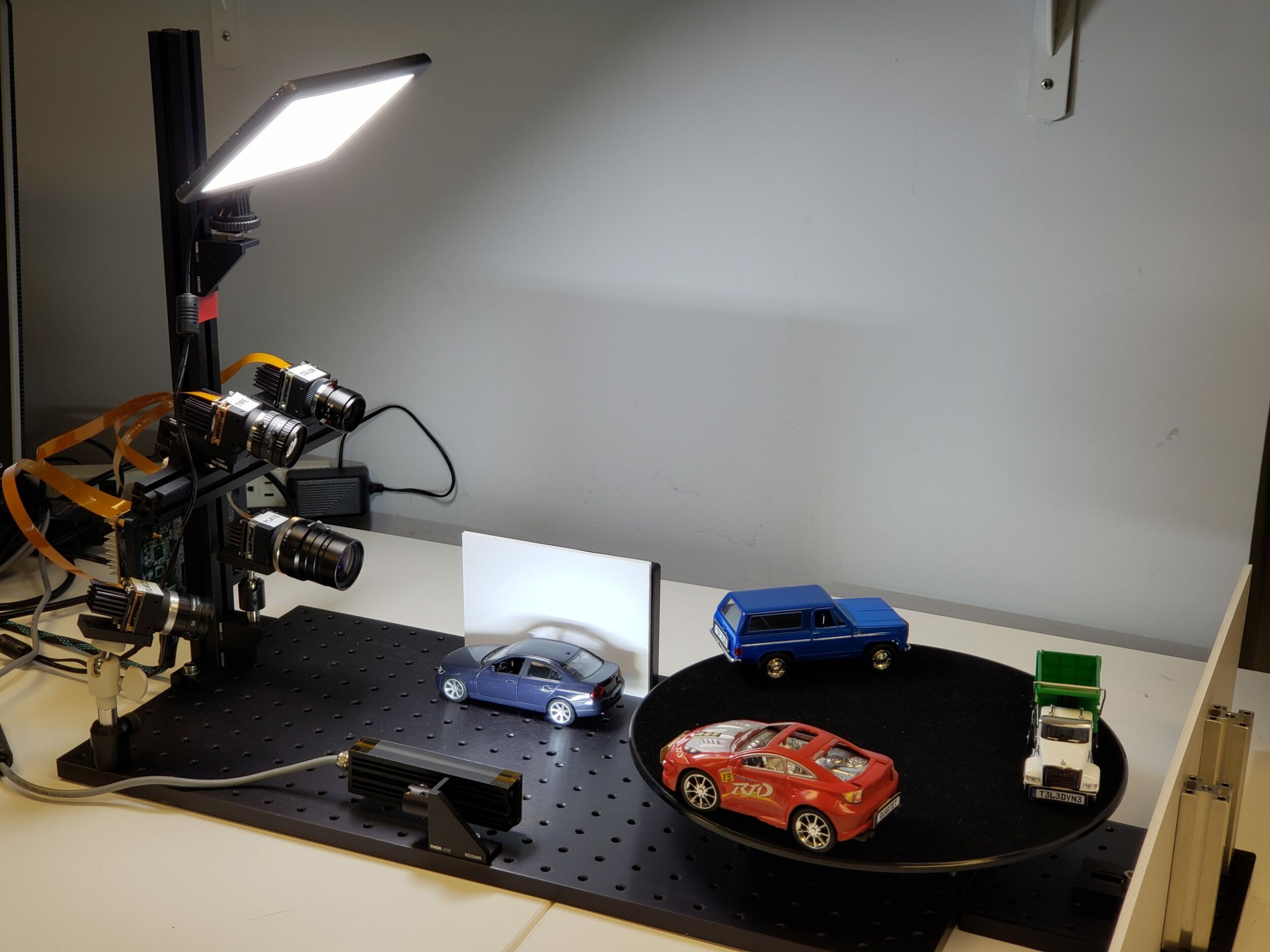

Immer mehr industrielle Applikationen setzen auf Embedded-Vision-Komponenten. Die Quartet Embedded Solution für TX2 von Teledyne FLIR ist auf besonders platzsparende Anwendungen ausgerichtet. Auf der enthaltenden Trägerplatine können bis zu vier Machine Vision-Kameras mit der Bandbreite von USB 3.0 angeschlossen werden. Das System beinhaltet den Deep-Learning-Hardwarebeschleuniger Nvidia Jetson TX2 und ist im Spinnaker SDK von FLIR vorintegriert. Kurz nach der Markteinführung berichtet der Hersteller von Anfragen von Anwendern, die damit Systeme für Inspektion, mobile Robotik oder Drohnen entwickeln wollen. Damit wird klar, dass beim Einsatz der Platine eine Fülle unterschiedlicher Möglichkeiten bestehen. Als Inspiration für eigene Projekte stellt dieser Artikel vier prototypische Anwendungen vor, die ersten drei verwenden das KI-Verfahren Deep Learning.

Kennzeichenerkennung

Für die Kennzeichenerkennung kam ein handelsübliches Deep-Learning-Modell von Nvidia zur Nummernschilderkennung (LPDNet)1 zum Einsatz, um die Position der Nummernschilder zu erkennen. Um die Buchstaben und Ziffern zu erkennen, nutzten die Entwickler bei FLIR die Tesseract Open-Source-OCR-Engine2. Bei der Kamera handelte es sich um eine Blackfly S 8,9 MP Platinenfarbkamera (BFS-U3-88S6C-BD) mit Sony IMX267-Sensor. Die Projektteilnehmer begrenzten die Region of Interest für die Kennzeichenerkennung, um die Leistung zu beschleunigen, und wendeten Tracking an, um das System robuster zu machen. Die Ausgabe enthält Begrenzungsrahmen der Kennzeichen zusammen mit den entsprechenden Nummernschildzeichen. Entwicklungszeit: Zwei bis drei Wochen, in erster Linie um das System robuster und schneller zu machen. Testbilder: In LPDNet enthalten Die neunte Ausgabe von Rockwell Automations „State of Smart Manufacturing“ Report liefert Einblicke in Trends und Herausforderungen für Hersteller. Dazu wurden über 1.500 Fertigungsunternehmen befragt, knapp 100 der befragten Unternehmen kommen aus Deutschland. ‣ weiterlesen

KI in Fertigungsbranche vorn

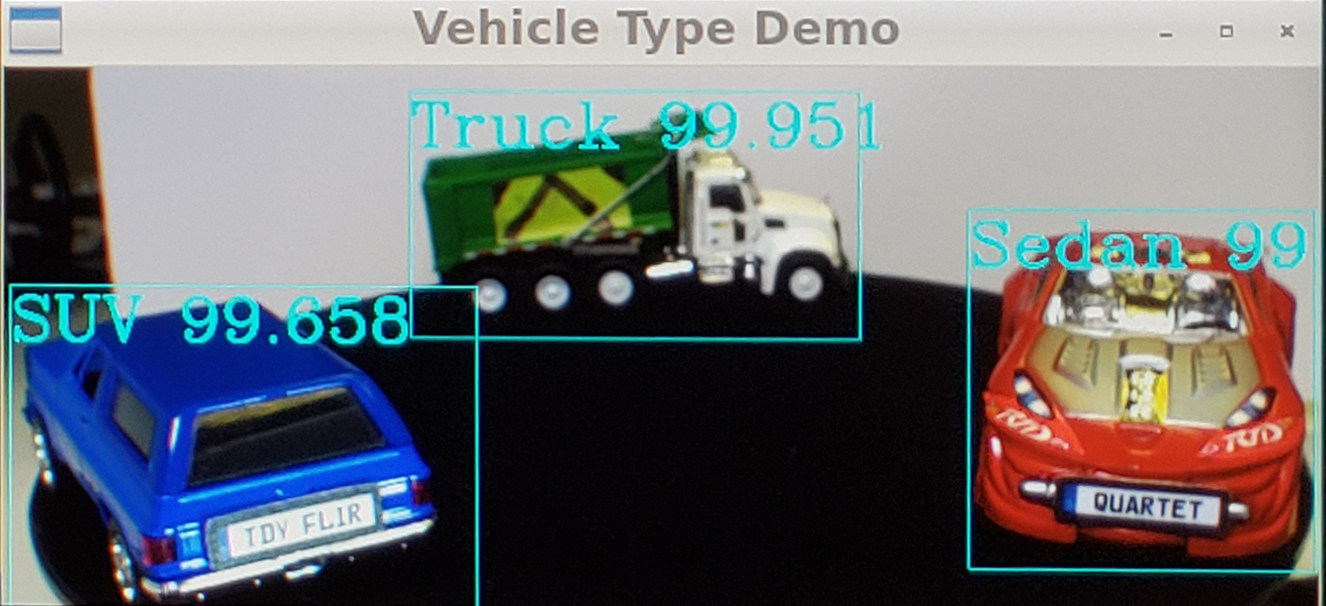

Fahrzeugtyp-Kategorisierung

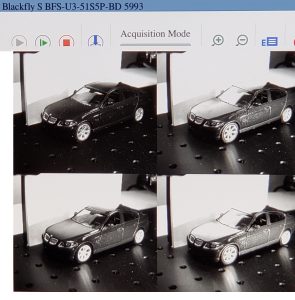

Für Anwendungsfall 2 ‚Fahrzeugtyp-Kategorisierung‘ mittels Transferlernen haben die Entwickler ein eigenes Deep-Learning-Objekterkennungsmodell auf drei Spielzeugautos SUV, Limousine und LKW trainiert. Es wurden etwa 300 Testbilder des Setups aus unterschiedlichen Entfernungen und Winkeln aufgenommen. Bei der Kamera handelte es sich um eine Blackfly S 5 MP Platinenfarbkamera (BFS-U3-51S5C-BD) mit Sony IMX250-Sensor. Die Mitarbeiter annotierten etwa drei Stunden lang die Begrenzungsrahmen der Spielzeugautos. Mittels Transferlernen trainierten sie das eigene Objekterkennungsmodell SSD MobileNet3, was auf einer Nvidia GTX1080 Ti GPU etwa einen halben Tag dauerte. Mithilfe des GPU-Hardwarebeschleunigers kann das Jetson TX2-Modul Deep-Learning-Inferenz durchführen und Begrenzungsrahmen der Autos zusammen mit den entsprechenden Fahrzeugtypen ausgeben. Entwicklungszeit: ca. zwölf Stunden, inklusive Bildaufnahme und -annotation, etwa 300 Testbilder.

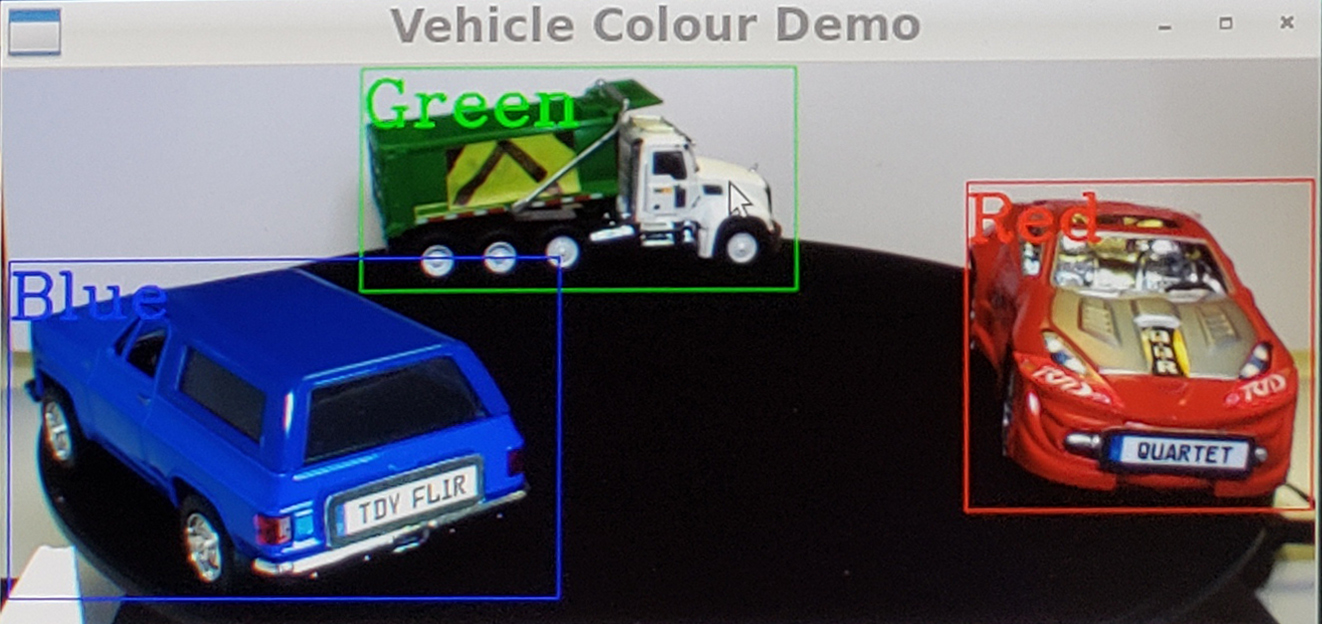

Fahrzeug-Farbklassifikation

Zur darauf folgenden Fahrzeug-Farbklassifikation wurde dasselbe Deep-Learning-Objekterkennungsmodell wie oben genutzt, um die Autos zu erkennen, gefolgt von einer Bildanalyse anhand der Begrenzungsrahmen, um die Farbe zu klassifizieren. Die Ausgabe enthält Begrenzungsrahmen der Fahrzeuge zusammen mit den entsprechenden Nummernschildzeichen. Bei der Kamera handelte es sich um eine Blackfly S 3 MP Platinenfarbkamera (BFS-U3-32S4C-BD) mit Sony IMX252-Sensor. Entwicklungszeit: Es konnte da breits vorhandene Modell zur ‚Fahrzeugtyp-Anwendung‘ genutzt werden, plus zwei Tage für die Erweiterung auf Farbklassifikation inklusive Integration und Test. Testbilder: Die 300 vorhandenen Aufnahmen.

Frontscheibeneinblick

Die Reduzierung von Blendlicht spielt bei verkehrsspezifischen Anwendungen eine bedeutende Rolle, um beispielsweise Einblick durch die Frontscheibe zu erhalten und so die Nutzung von Sonderspuren für Fahrzeuge mit hoher Besetzung (HOV-Spuren), die Einhaltung der Gurtpflicht und sogar die Handynutzung während der Fahrt zu kontrollieren. Zu diesem Zweck entstand im Projekt eine kundenspezifische Kamera, die eine Blackfly S USB3-Platinenkamera mit dem 5-MP-Polarisationsfilter Sony IMX250MZR kombinierte. Teledyne FLIR kann verschiedene Sensoren von Kameras austauschen, um individuelle Kameraoptionen zu ermöglichen, hier um deren Funktion zur Blendlichtreduzierung zu demonstrieren. Dazu wurden die Kamerabilder über die SpinView-GUI von Teledyne FLIR gestreamt, die verschiedene ‚Polarisationsalgorithmus‘-Optionen wie Quad-Modus und Blendungsreduzierungsmodus bietet, um Blendlicht an einem stehenden Spielzeugauto zu reduzieren. Der Thin[gk]athon, veranstaltet vom Smart Systems Hub, vereint kollaborative Intelligenz und Industrie-Expertise, um in einem dreitägigen Hackathon innovative Lösungsansätze für komplexe Fragestellungen zu generieren. ‣ weiterlesen

Innovationstreiber Thin[gk]athon: Kollaborative Intelligenz trifft auf Industrie-Expertise

Gesamtsystemoptimierung

Während jeder der vier Prototypen unabhängig voneinander gut funktionierte, stellten die Projektteilnehmer bei der gleichzeitigen Ausführung aller Deep-Learning-Modelle eine ziemlich mangelhafte Gesamtleistung fest. Das TensorRT SDK von Nvidia bietet einen Deep-Learning-Inferenzoptimierer und eine Laufzeit der Nvidia-Hardware ähnlich dem Jetson TX2-Modul. Also optimierten die Entwickler die Deep-Learning-Modelle mithilfe des TensorRT SDK, was zu einer rund 10-fachen Leistungssteigerung führte. Zudem statteten sie das TX2-Modul mit einem Kühlkörper aus, um eine Überhitzung zu vermeiden, die beim gleichzeitigen Betrieb aller Anwendungen zu befürchten war. Schließlich gelang es, mit allen vier Anwendungen gleichzeitig gute Bildraten zu erzielen: 14B/s für die Fahrzeugtyp-Identifikation, 9B/s für die Fahrzeug-Farbklassifikation, 4B/s für die automatische Kennzeichenerkennung und 8B/s für die Polarisationskamera. Die Projektteilnehmer bewerten ihre Versuche als Erfolg, denn die Prototypen ließen sich in relativ kurzer Zeit entwickeln und grundlegend optimieren. Das TX2-Modul mit vorinstalliertem Spinnaker SDK sorgt für Plug&Play-Kompatibilität mit den Blackfly S-Platinenkameras und Nvidia bietet zahlreiche Tools, um die Arbeit mit dem TX2-Modul zu erleichtern. Interessierte Unternehmen können Quartet ab sofort über das vertriebsnetz des Herstellers oder direkt über dessen Websites erwerben. Eigenen Versuchsreihen auf dem Weg zur Spezialapplikation steht somit nichts im Weg.

- Die Quartet-Trägerplatine für TX2 von Teledyne FLIR. Sie bietet vier TF38-Anschlüsse mit dedizierten USB3-Controllern und ein Nvidia Jetson TX2-Modul. Das Spinnaker SDK des Herstellers ist vorinstalliert, was Plug&Play-Kompatibilität mit den Blackfly S-Platinenkameras ermöglichen soll.

- Drei Standard-Platinenkameras der Reihe Blackfly S

- Eine kundenspezifische Platinenkamera mit Sony IMX250MZR-Polarisationssensor

- TF38-FPC-Kabel, die Strom und Daten über ein einziges Kabel übertragen können

- LED-Leuchten beugen etwaiger Bewegungsunschärfe vor